初音ミクとの出会い「産総研P誕生秘話」

――今回記事の一番最初に「産総研P」とか「南極点のピアピア動画」の話題に触れましたが、後藤さんは初音ミクの研究をしている人って印象も強いと思うんですね。

未来を視るという意味では、後藤さんはすごい早い段階で初音ミクとかニコニコ動画を研究に取り込んでいたのも特徴的だと思います。ここに目を向けたきっかけというのはなんだったんですか?

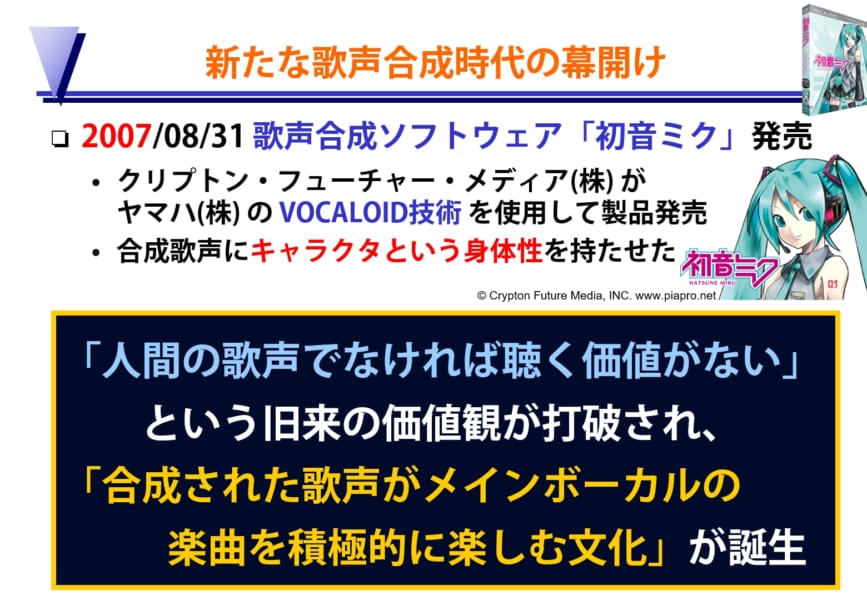

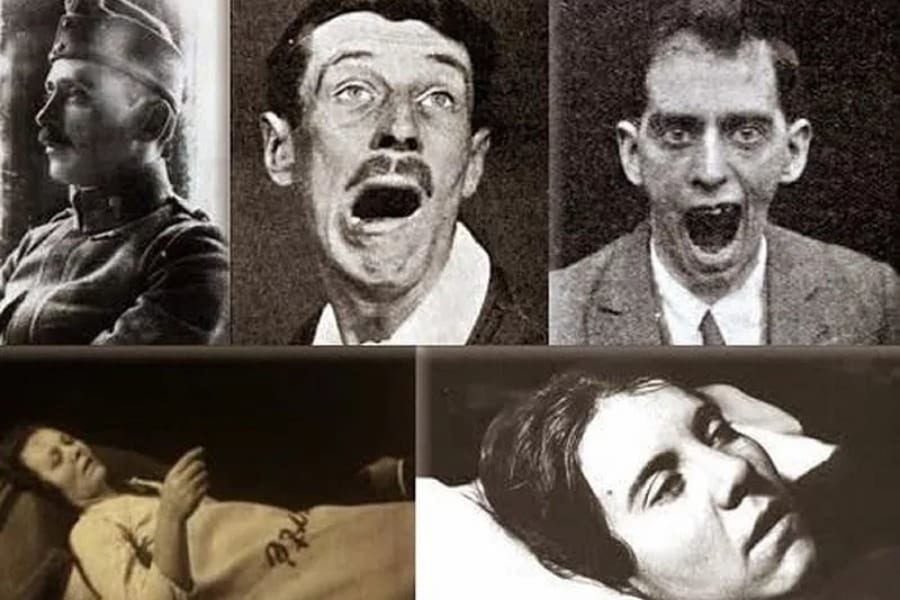

後藤:歌声合成技術の研究発表は1990年代からいろいろと見ていて、初音ミク以前にもいろいろな製品が発売されていました。中学生のとき、店頭のPC-6601に歌わせたこともあります。だから、もちろん技術的には知っていたんですが、初音ミクが当時登場した衝撃というのは、この技術が一気に普及して人々の価値観を変えたことと、ユーザーのクリエイティビティを引き出して連鎖させたところにあると思っています。

――確かに今でこそ初音ミクのお姉さんとお兄さんという形で人気になっていますが、MEIKOとKAITOって出てきたときは私の周りでDTM(パソコンで音楽を編集すること)を趣味にしている人でも、これで歌声と呼ぶのは厳しいよねという感じで、あまり注目されていなかったですね。

なので初音ミクの登場で、機械で合成された歌声にみんなが魅了されたっていうのはかなり驚きでしたね。

後藤:まさか合成された歌声がメインボーカルの楽曲をみんなが楽しむようになるとは、予想できませんでした。それまでの常識として、人間の歌声でなければ聴く価値がないという暗黙の価値観があったので。その古い価値観が打破されました。

初音ミクの発売は2007年8月31日なんですが、私が幸運だったのはこのときヤマハのVOCALOID開発者である剣持秀紀さんと、ベルギーのアントワープの国際会議でお会いしていたことでした。

初音ミクも会場で展示されていて、こんな製品が出るんですよって見せていただいて、日本のほとんどの人が知るよりもいち早く国際会議で開発者本人からデモを交えて紹介してもらえたんです。初音ミクの発売もこの会議中でした。

それで、ちょうど目の前の剣持さんに日本から国際電話があって、電話を切った瞬間に「後藤さん、初音ミクが量販店の店頭で売り切れましたよ!」と教えてくれたんです。私もそこでなにかすごいことが起きているって認識できたんです。

――初音ミクは発売直後からすごい人気でずっと売り切れ騒動みたいなのが続いていましたよね。欲しくても全然手に入らないという人が続出して。

後藤:そこからはもうニコニコ動画に毎日のように新しい作品が投稿されていくのをチェックして、いかにすごいことが起きているのかというのを目の当たりにしながら、いろいろと考察していました。

――後藤さんは、ここまでの紹介の中でもクリエイター側の創作支援に関する技術に触れられていましたよね。こうした1つのソフトの発売で大勢の人々の創作意欲が爆発して次々に新しいコンテンツが生み出されていくというのは、もうそれだけでかなり驚くべき現象だったんですか?

後藤:そうですね。N次創作と呼ばれる創作の連鎖が次々と起きて、楽曲が作られるだけではなくて、PVを別の人が付けたり、「歌ってみた」「踊ってみた」のような派生作品がどんどん生まれていきました。

それと、初音ミクが発売されて数カ月の間に、歌声合成の声の高さや大きさのパラメータを巧みに調整して、人間らしく自然に聞こえる歌声を作り出すことに力を入れた作品が投稿されていたんです。

――ネットでは調教と呼ばれていた自然な歌声に近づけるための調整ですね。これが上手いと「神調教!」と盛り上がっていましたね。

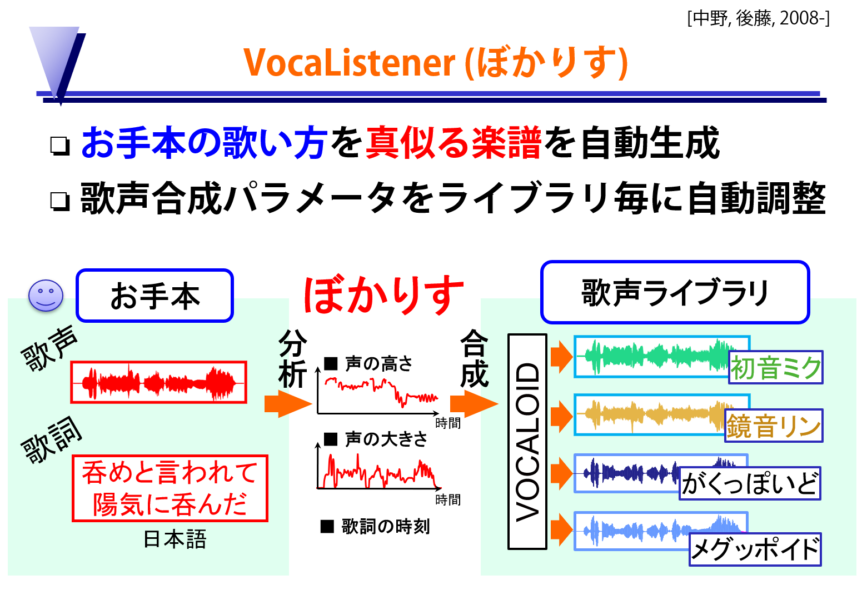

後藤:それを見ていて、私たちの音楽理解技術を応用すればもっと自然に合成できるということに気づいて、当時は若手研究者だった中野倫靖と一緒に作ったのが「VocaListener(ぼかりす)」です。これは人間のお手本の歌い方を解析してVOCALOIDの歌声合成パラメータを作り出すことで、自然な歌声を合成できる技術です。人間が歌うだけでそれを真似て調整できたので、個性的なビブラートや、演歌のような複雑な歌い方も合成できました。

――これほんと自然な歌声に聞こえてすごいですよね。この「ぼかりす」のデモを公開したことが「産総研P」という呼び名が誕生したきっかけですね。ただ何よりびっくりなのは、これが初音ミクが発売されて半年とかそれくらいですぐに出てきたことです。

私も当時これを見ていて、みんなが初音ミクをもっと自然に歌わせられないかって調教に苦労していたときに、いきなりポンと人間が歌えば自動で調整できますって技術デモが出てきて、なんじゃこりゃ、もうこんなのがあるのかって驚いたのをよく覚えています。

後藤:これがいち早く実現できたのは、技術の蓄積があったからです。1998年に博士の学位を取得して研究所に就職してから、私は音声認識とか音声インタフェースに関する研究も同時並行でやっていたんです。

――え、こんだけ成果があるのに、まだ他にも色々と裏で研究なさっているんですね。

後藤:一方で、音楽理解技術としては、沢山の音が混ざっている音楽の中から歌声を抜き出す世界初の技術も1998~2000年ごろに私は実現していて、その歌声を使うと、いろいろな新しい研究テーマを思いつける状態でした。それで2000年代には、次のフロンティアは歌声関連の技術だと考えて、かなり力を入れていたんです。

というのも歌声って、音楽と音声の両方の側面があってどちらの技術も必要だから、どちらの研究分野からも難しくて手が出しづらい状況だったんです。

音楽情報処理の立場から見ると、楽器音と違って、声のような音素が次々と変わっていく音響信号って、難し過ぎてなかなか上手く解析できない。一方、音声認識の立場から見ると、話し声と違って、歌声って母音が伸びたり高さが大きく変動したりするから、一番難しい種類の声で上手く認識できなかったんです。

なので歌声の研究って、まだ取り組まれていない研究テーマが沢山あることに気づいたんです。そこで私たちの音楽理解技術と音声認識技術の蓄積で、いろいろな研究に取り組んで発表していました。私はそれを2008年に振り返って、「歌声情報処理」と名付けています。

さきほどお話した剣持さんとお会いした国際会議でも、そうした歌声関連の研究成果を発表していました。

――じゃあ、「ぼかりす」はその両輪で研究を進めた成果があったからこそ、あんなにすぐ発表できたということなんですね。

後藤:そうですね。技術の蓄積がなければ不可能でした。

そのため、私たちの「ぼかりす」のデモには、VOCALOIDを開発したヤマハ自身も「こんなことができるのか!?」と驚いて。そこで製品化しましょうとヤマハからご提案をいただいて、実際に発売されることになりました。

――過去の蓄積が活きているというか、基礎研究がいかに重要かってお話しですね。

後藤:その通りで、技術と知見が蓄積しているからこそ、普通は長期間かかる開発も、短期間でできることはよくあります。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)