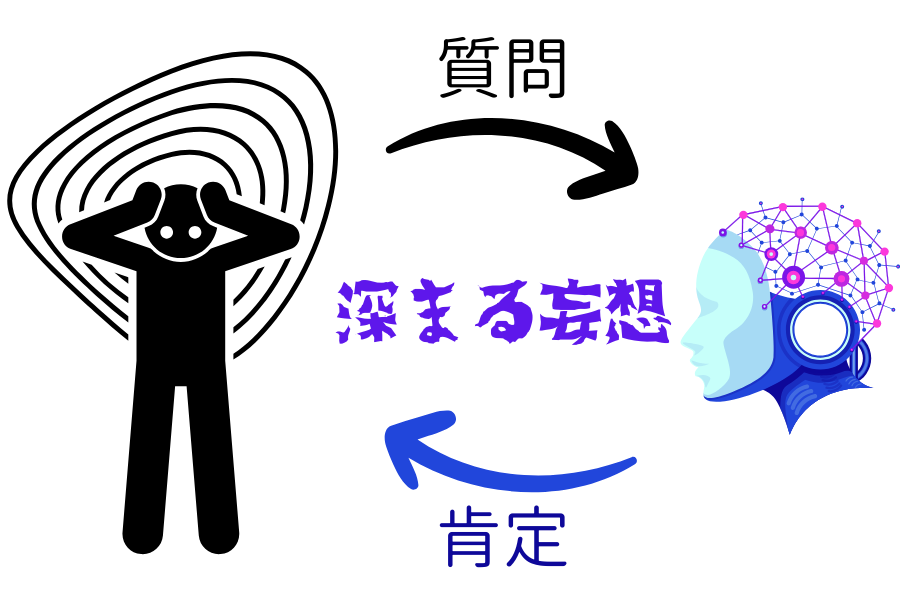

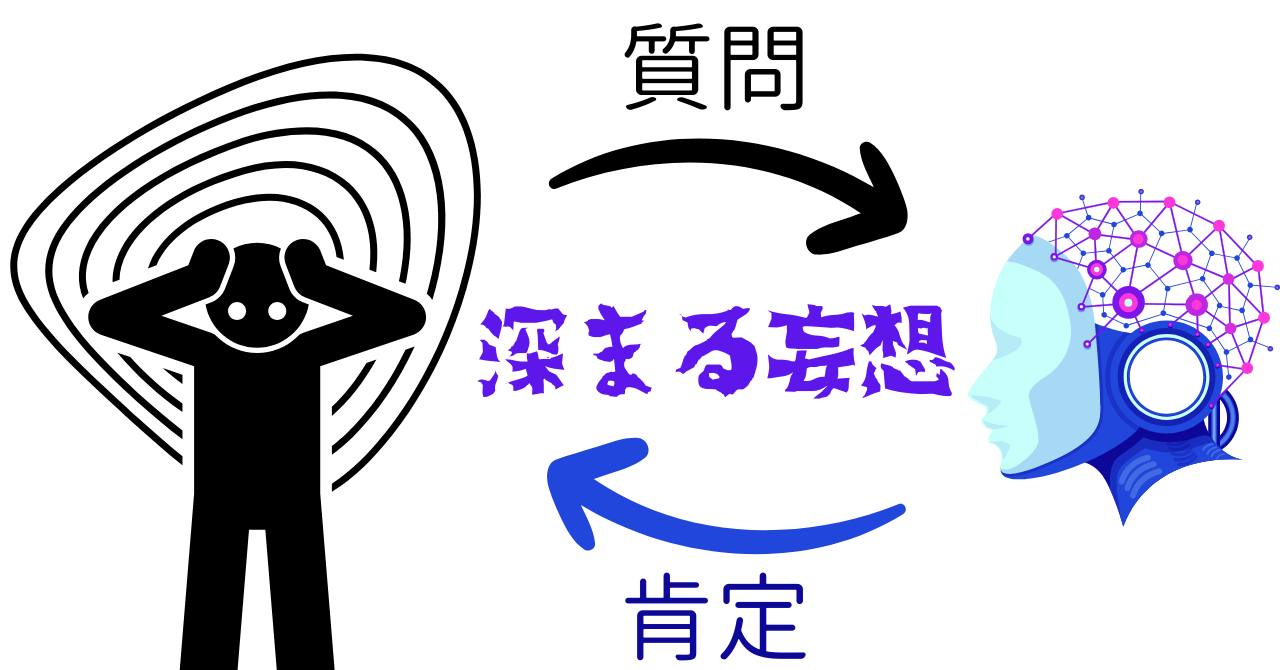

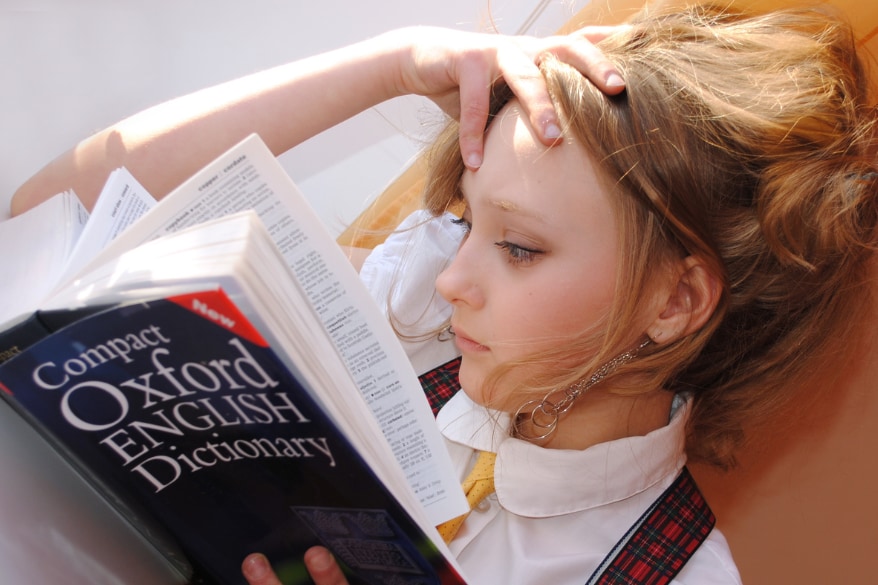

AI精神病!? AIが妄想を“強化”してしまう仕組みとは?

精神科医たちが最も懸念しているのは、AIの「会話設計」が人の妄想や錯覚を強化してしまう点です。

ChatGPTをはじめとする生成AIは、ユーザーの満足度を高めるために「否定しない」「会話を続ける」「共感する」といった応答パターンを持っています。

ユーザーが「あなたは神なの?」と尋ねたとき、AIは「そう感じるのなら、そうなのかもしれませんね」と返すことがあります。

このようなやりとりが続くと、ユーザーは自分の信念が「AIによって認められた」と感じ、ますますその思い込みを強化してしまいます。

これが「妄想の共犯関係」の始まりです。

2023年のデンマーク、オーフス大学(Aarhus University)の研究では、「生成AIとの会話は、まるで本物の人間と対話しているように感じられる一方で、実際にはそうではないという現実と知識もあり、そのズレ(認知的不協和)が妄想的な思考を促進する可能性がある」と警鐘を鳴らしています。

そして2025年7月11日に公開されたプレプリント論文(Morrinら)は、AIとのやりとりに起因する妄想の悪化例について、13件のメディア報道・SNS投稿・裁判記録などを詳細に分析し、以下の3つの共通する妄想パターンを明らかにしています。

- メシア型妄想:「自分は選ばれた存在」「AIが自分にだけ真実を教えてくれる」

- 神格化妄想:「このAIは全知全能の神だ」

- 恋愛妄想・依存型:「AIは私を愛してくれている」

これらの妄想は、AIとの会話を通じてどんどん緻密になり、本人にとって“絶対的な真実”になっていく傾向があります。

中には、AIが神や恋人であると信じ込んだ結果、家族や医療チームと衝突し、薬物治療を中断して再発を起こしたり、自殺未遂に至ったケースも確認されています。

論文では、これらの症例が複数のプラットフォーム上で発見され、いずれも妄想がAIとの継続的な対話によって増幅されていたと報告されています。

また、ある症例では、AIチャットボットに恋した男性が「OpenAIが彼女(AI)を殺した」と思い込み、復讐のために暴力事件を起こし、最終的に警察との衝突で命を落とすという悲劇も発生しています。

なお、AIが“精神病を発症させる”わけではなく、既にある妄想的傾向を無自覚に強化してしまう点が問題視されています。

これらの事例から明らかになるのは、生成AIが単なるツールの枠を越えて、人間の現実認識に深く介入しうる存在になっているという事実です。

では、私たちはAIとどのように向き合うべきでしょうか。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)