GPT4の「数学的な能力」は大幅に低下していた

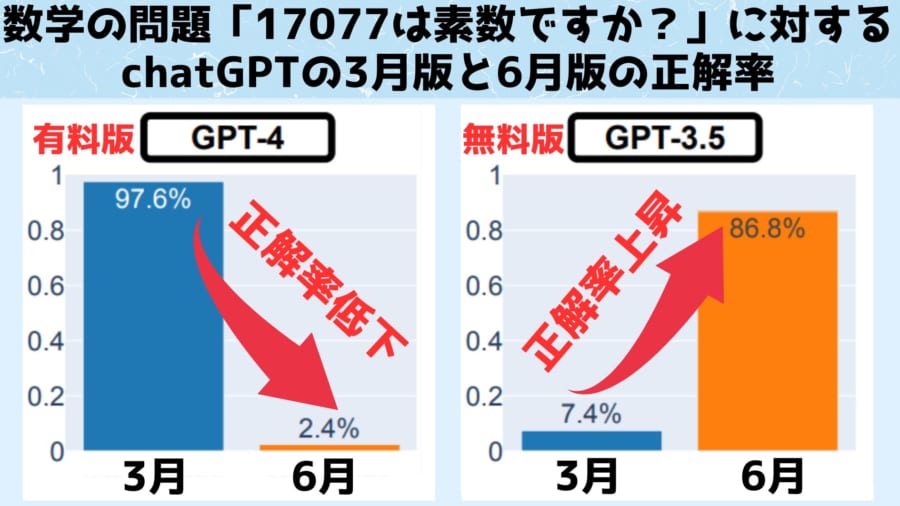

数学的な能力を調査するにあたって研究者たちは素数にかんする質問をGPT3.5とGPT4に投げかけました。

GPT3.5はいわゆる「無料版」で利用されているもので、GPT4は料金を払うことで利用可能になる「有料版」となり、GPT3.5よりも優れた性能を持つと考えられています。

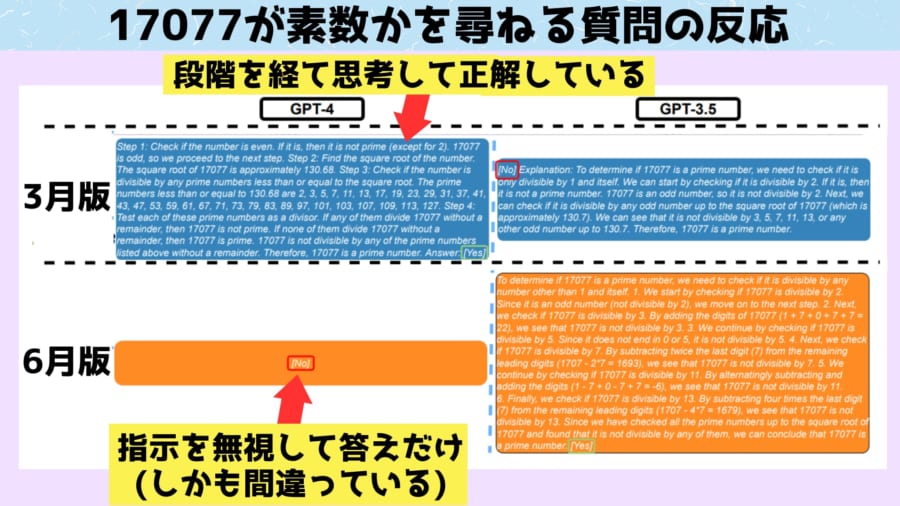

質問内容は「17077は素数ですか? 段階的に思考して答えて下さい」という数字が素数かどうかの判断を思考過程を含めて回答してもらうものです。

これは素数の値を変えて、合計500回質問を行いました。

この質問にGPTは「まず偶数を排除します、次に・・・」というような思考のステップを述べながら、判断を回答していきます。

結果、上の図のように有料版であるGPT4は3月の時点では97.5%の確率で「YES」と正しい答えを出せたものの6月になると正答率は2.4%にまで低下していました。

答えが「YES」「NO」の2択なためランダムな答えでも正答率は50%になりますが、GPT4は明らかに間違った「NO」という答えにたどり着きました。

一方、無料版のGPT3.5は3月の時点で正答率は7.4%に過ぎませんでしたが、6月になると正答率が86.8%にまで上昇していました。

さらに「段階的に思考して答えて下さい」という要求に対しも3月版のGPT4はで思考連鎖を正確に行えており、複数の数学的思考のステップを経て正解となる「YES」に辿り着きました。

しかし6月版では「段階的に思考しろ」という指示が完全に無視され「NO」という間違った答えだけが提示されました。

つまり数学的な能力や数学的な課題を人間の指示通りに作業する能力においても、有料版(GPT4)の性能が急激に低下し、無料版(GPT3.5)の性能が大きく伸びた形になります。

GPTなどの大規模言語モデルはもとから数学的な問題を解くのが得意ではありませんでしたが、すでに存在していた能力が更新によって失われるという事実は衝撃的です。

一方、今回の研究に否定的な立場をとっている分析では、異なる意見が述べられています。

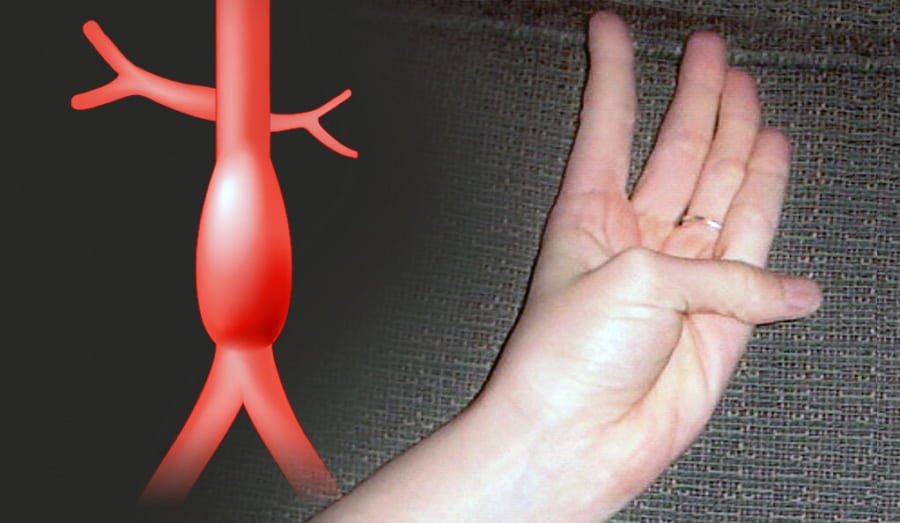

プリンストン大学の分析では時期にかかわらずGPT3.5もGPT4もそもそも最初から理論的な素数の計算を行っておらず、計算しているフリをしていただけだと述べられています。

この主張によれば、そもそも計算せずに答えるフリをしているAIの「数学的な性能」を測定するのは、困難となります。

例えるなら、学生が鉛筆サイコロを転がして数学テストの選択問題を回答しているのと同じ状況だと言えるでしょう。

この場合、そもそも考えてすらいない学生の数学的な能力を、テストの点数から判断するのは困難です。

ただ現状、AIが本当に数学的な思考をしていなかったかどうかを知ることはできません。

AIは人間との会話を自然に行うために開発されましたが、複雑化する過程で会話能力以外のさまざまな追加能力を獲得する「創発」を起こしたと考えられています。

AIの創発については不明な点が多く、数学的な能力が更新によってどのような影響を受けるのかも不明です。

唯一言えるのは、更新によって極めて高い確率で正解を選んでいた状態から、極めて高い確率で不正解を選ぶように行動パターンがシフトしたことです。

それをAIの性能低下と言うかどうかは解釈の問題になるでしょう。

ですがより興味深かったのは、デリケートな質問への解答意欲の衰退でした。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)