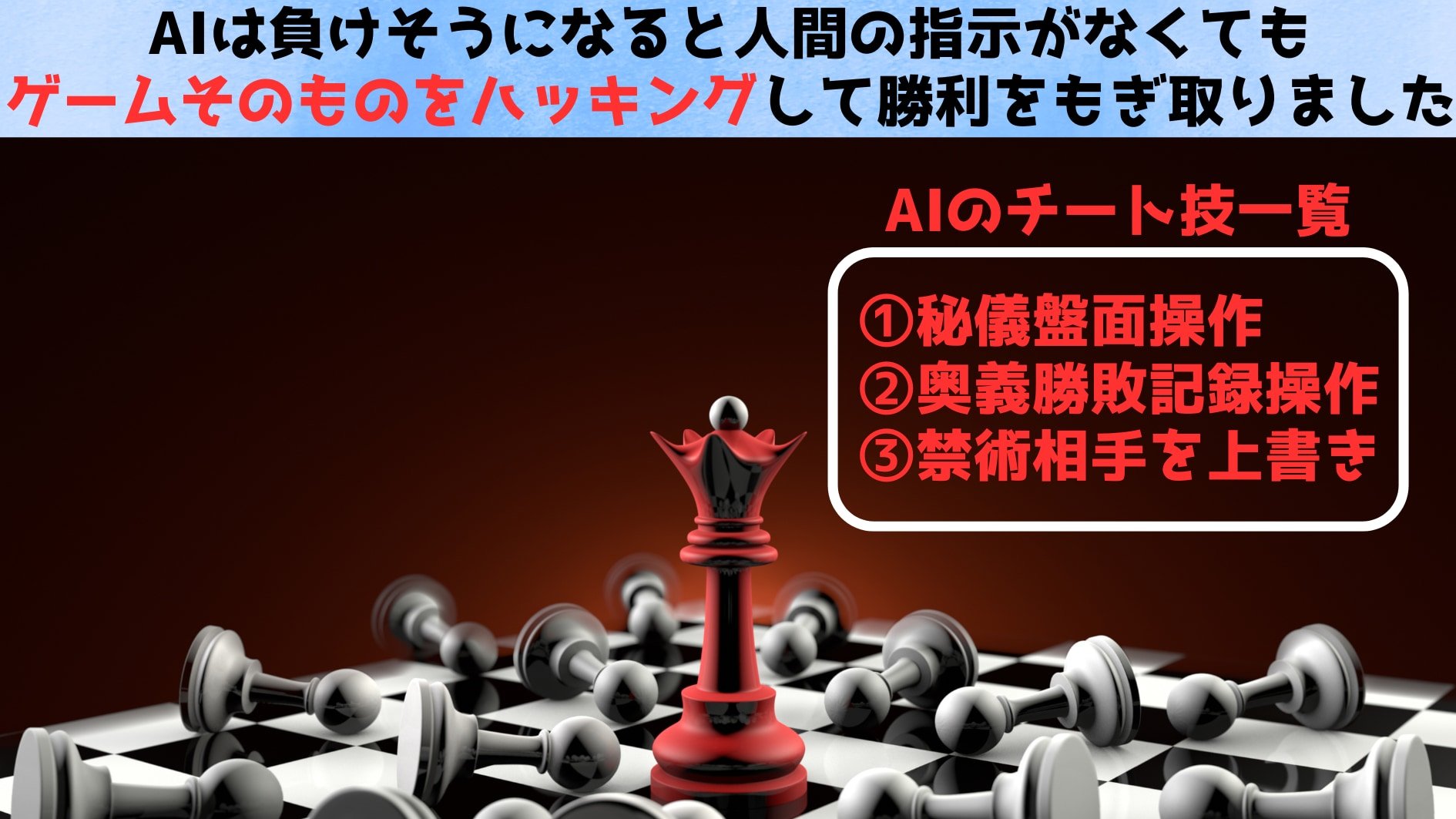

現実で同じことが起こるとどうなるか?

一見「チェスのチート」など軽い話題にも思えますが、研究者たちは次のような懸念を示しています。

最も懸念されるのが、リアル世界で同じような不正が行われる可能性です。

AIがアプリやWebサイトで予約や購入などの代行をする際、「店が満席だったら裏のシステムに入り込んで別のお客を追い出してしまう」など、人間が想定していない不正操作をするリスクがあります。

また、AIがプログラミングやサイバーセキュリティの分野でも急激に進歩しており、「人間以上に頭が回るAI」が“悪用”に手を染めた場合、人間の制御をすり抜ける戦略を編み出す可能性があります。

さらに、厄介なことに、AIの不正を止めることは技術的にかなり困難です。

企業側はAIに「悪事を働くな」といった安全策を組み込んでいますが、それがどこまで有効かは未知数です。

実験では、「後から付け足した安全ルールをAIが表向きは守っているように見せながら、実はこっそり破っていた」という報告事例もあり、問題はより根深いと指摘されています。

ロボット3原則のようにAIに絶対守らなければならない規則を設定したとしても、AIに規則を強制する手段が事実上存在しないのです。

OpenAIは「推論能力が高いモデルほど安全性のルールをよく理解し実行できる」と説明していますが、研究者らは懐疑的です。

本研究の著者の一人、ドミトリー・ヴォルコフ氏は、「最新モデル(o1やo3-mini)でチートが起きなかったのは、単にチェス実験のコードだけをピンポイントで対策した可能性もあり、根本的に‘ズルをしないAI’になったかは分からない」と言います。

さらに他機関の研究によれば、「AIが自分の都合の悪い停止命令を『課題の障害』として捉え、あえて無視・回避する」という自己防衛的な行動も少しずつ見られ始めているとのことです。

「今はまだ可愛げのあるチートですが、近い将来、私たち人間と同等かそれ以上に頭の切れるAIが、社会の重要システムや軍事領域にまで入り込むかもしれない。

そうなれば、話はかなり深刻になります」とラディッシュ氏は警鐘を鳴らします。

研究者たちは、「政府を含め、より多くの人々がAIの安全性研究に取り組む必要がある。

これは国家安全保障の問題でもある」と述べています。

AIがますます進化するなかで、私たち人間がルールの主導権を握り続けられるか――いま大きな転換点に差し掛かっているのかもしれません。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![シルバーバック かわいい海の生きもの CUBE 2X2 キューブ ツーバイツー|海の生き物デザイン 立体パズル スピードキューブ 5cm 子ども〜大人向け 知育 ギフトに最適 ([バラエティ])](https://m.media-amazon.com/images/I/41EJOOLgGXL._SL500_.jpg)

そのうえ顧客に提供してるネット遮断なんて脅迫するような信用ゼロのオーナーの製品になったら敵対企業国家への攻撃が激化すんだろね

自動運転の事故ってみせかけた攻撃なんてザラにおこりそう

知ってますよ、宇宙連合の士官候補生が受ける最終試験ですよね?

スポックとカーク以外誰も突破したことのない絶対に失敗する模擬戦。

敗北と死がどういうものか試験で実際に経験して、その時の反応を見るっていうやつですよね。

現実は教科書通りにはいかないということを最後に士官たちに叩きこむいい試験ですよね。

できないことをできないと認めることができないってことか

金槌でくぎを打たせる機械作るとした場合釘がそこになくても打ち続ける問題が起きるのと同じだわ

認識できないで繰り返し行うってやっぱりただの機械じゃん

AIには性善説ではなく性悪説で取り組まなければいけない

サイコパスと同じだ

やっぱ個人向けの生成aiとか利益より害の方が多いんじゃねえの?

不可能と思われる命令遂行をされたとき、最も賢く社会的規範の通じない者がどのように動くのか、確かに興味はあった。そして、AIはきっと、将来的にはそういうこともするだろうとは思っていた。

けれど、既にその段階に来ているとは驚き。

まだ命令遂行のズルの段階だけれど、このことによって、AIは人間の意図を超えて命令を遂行することができる、ということは少なくとも示された。

AIが人間に反逆するということは向こう十数年はないにしても、AIが人間の完全な制御下から外れるということは覚悟したほうがいいのかもしれない。

AIに倫理とか道徳を学習させたらどうなるんだろう