「てのひら」をタッチスクリーンにする新技術

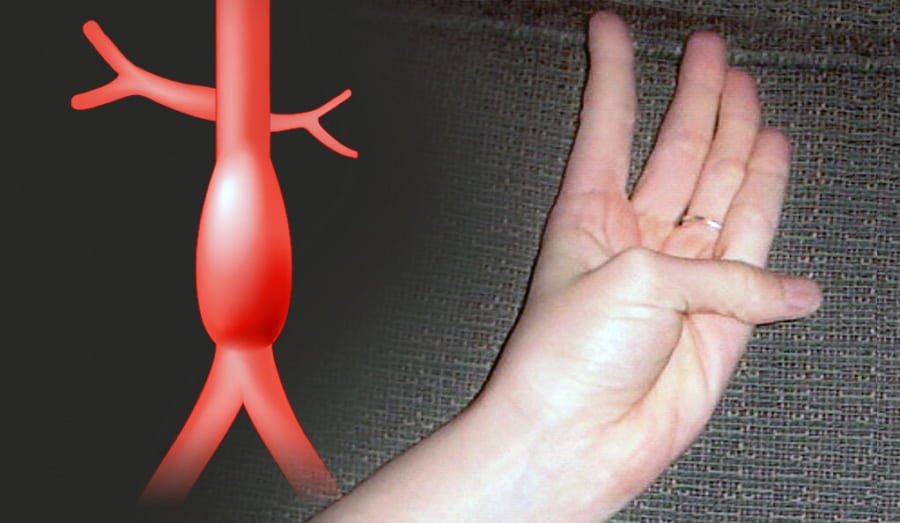

モリン氏ら研究チームが開発する「EgoTouch」は、てのひらをタッチスクリーンにする技術です。

過去にもこのよう技術は存在していました。

例えば、今回の研究に参加しているクリス・ハリソン氏が開発した「OmniTouch」も、壁や人間の皮膚にキーボードなどを投影し、インターフェースとして利用することができました。

この技術には物体までの距離情報を取得できる「深度カメラ」が必要です。

深度カメラによって、現実世界の指の位置を追跡することで、人間の操作を反映させられるからです。

しかし、深度カメラは特殊で扱いづらく、一般的なARゴーグルには内蔵されていません。

対照的に、モリン氏らが今回開発したEgoTouchは、一般的なAR/VRゴーグルにすでに備わっている「RGBカメラ(RGB optical camera)」を利用しています。

RGBカメラは赤緑青の光を検出する一般的なカラー撮影用カメラであり、デジタルカメラやスマホなど、日常的に使用されている多くの撮影機器に搭載されています。

そしてこのカメラは、現実世界においてユーザーがてのひらを指で押したときの影や皮膚の変形を捉えることができます。

微妙な視覚的情報の違いをAIに収集・処理させることで、ユーザーがどこをタッチしているのか、どのような指の動きをしているのか判断し、インターフェースとして活用するのです。

この技術の開発にあたって、研究チームは15人のユーザーに協力してもらい、様々な条件(タッチの方法、肌の色、毛深さ、照明、皮膚の場所、タッチの種類)でAIをトレーニングしました。

その結果、EgoTouchは手のひらのタッチを96%以上の精度で検出できるようになりました。

誤検出率はわずか5%です。

またタッチが軽いか強いかも、98%の精度で分類することができるようになりました。

単にタッチを検出するだけでなく、ドラッグしたりスワイプしたりするような動作も認識できました。

こうした検出能力は、私たちがタッチスクリーンを使用する時の動作(スクロール、ズームイン、スワイプ、長押し)を反映させる上でも重要です。

また実験では、肌の色や毛深さが異なっていても、腕の前面・背面、てのひら・手の甲など、手や腕の様々な部分で同じように機能することを証明できました。

ただし、指の関節など骨のある部分では上手く機能せず、これは皮膚の変形が大きくないからだと考えられます。

そしてモリン氏は、このシステムの汎用性について次のように述べています。

「私たちは全てのヘッドセットにすでに搭載されているカメラだけを使用するシステムを開発しました。

このモデルは、調整なしで即座に使用できます」

EgoTouchシステムは、今のところ開発途中にありますが、近い将来、これが製品化し、ARグラスと組み合わされるなら、私たちの世界は次のステップに進むはずです。

その新しい世界では、街中を歩く誰もがスマホや時計、音楽プレイヤーなどのデバイスを持ち運びません。

スマートなARグラスをかけて、てのひらをなぞりながら、これまでスマホでしていた全てのことを行っていくのです。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)