トロッコ問題は現実的ではなく、その結果はドライバーの道徳的な判断を反映していない

AIに人間のドライバーのような判断能力を持たせるためには、膨大なデータを与えてトレーニングする必要があります。

では、多くの人にトロッコ問題を行わせて、その判断結果を用いてAIをトレーニングするなら、AIの判断能力は向上するのでしょうか?

チェッキーニ氏ら研究チームは、「そうはならない」と主張しています。

なぜなら、トロッコ問題の結果は、人々の差別的な考えを反映している可能性があるからです。

例えば、ある種のトロッコ問題では「男か女か」「子供か高齢者か」を必ず選ばなければいけません。

これらの結果の傾向は時代や地域で異なります。

そして実験を行った時代特有の、もしくは地域特有の偏見や差別的な考えを排除しきれないのです。

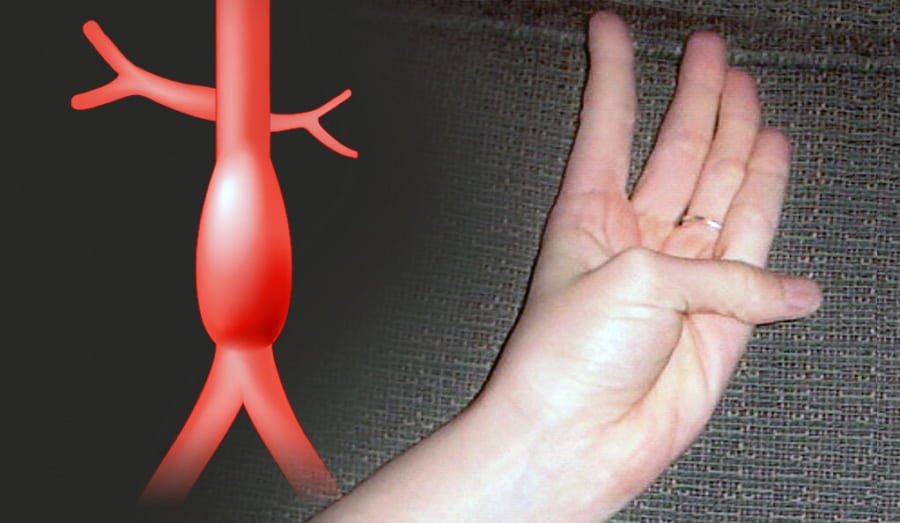

また、トロッコ問題を用いるべきでない別の理由として、トロッコ問題には「生態学的妥当性」が欠如しているという点が挙げられるようです。

生態学的妥当性とは、限定的な条件で行われた研究結果が、現実の幅広い局面でどの程度通用するかを示すものです。

これについて考えた場合、トロッコ問題のような限定的な条件は現実ではほとんど生じないため、実践的なデータとしては利用できずAIのトレーニングに向かないというのです。

確かに、「ドライバーが死ぬか、歩行者が死ぬか」「大人をひくか、子供をひくか」といった絶対的な2択が生じる状況など、めったにありません。

そのため、ほとんどの回答者は、問題に回答しようと悩んでいる時でさえ、人の命が本当に失われるかのような深刻な気持ちにはなりません。

むしろ、トロッコ問題をゲームのような感覚で「楽しみながら」回答する人の方が多いでしょう。

当然、それらの結果を集めて、AI(自動運転システム)をトレーニングしたとしても、人間の道徳的な判断が反映されることはないのです。

研究チームはこうした考えから、AIをトレーニングする際に、あえてトロッコ問題を排除しました。

そして彼らは、ドライバーが日々直面している、より現実的な判断に注目しました。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)