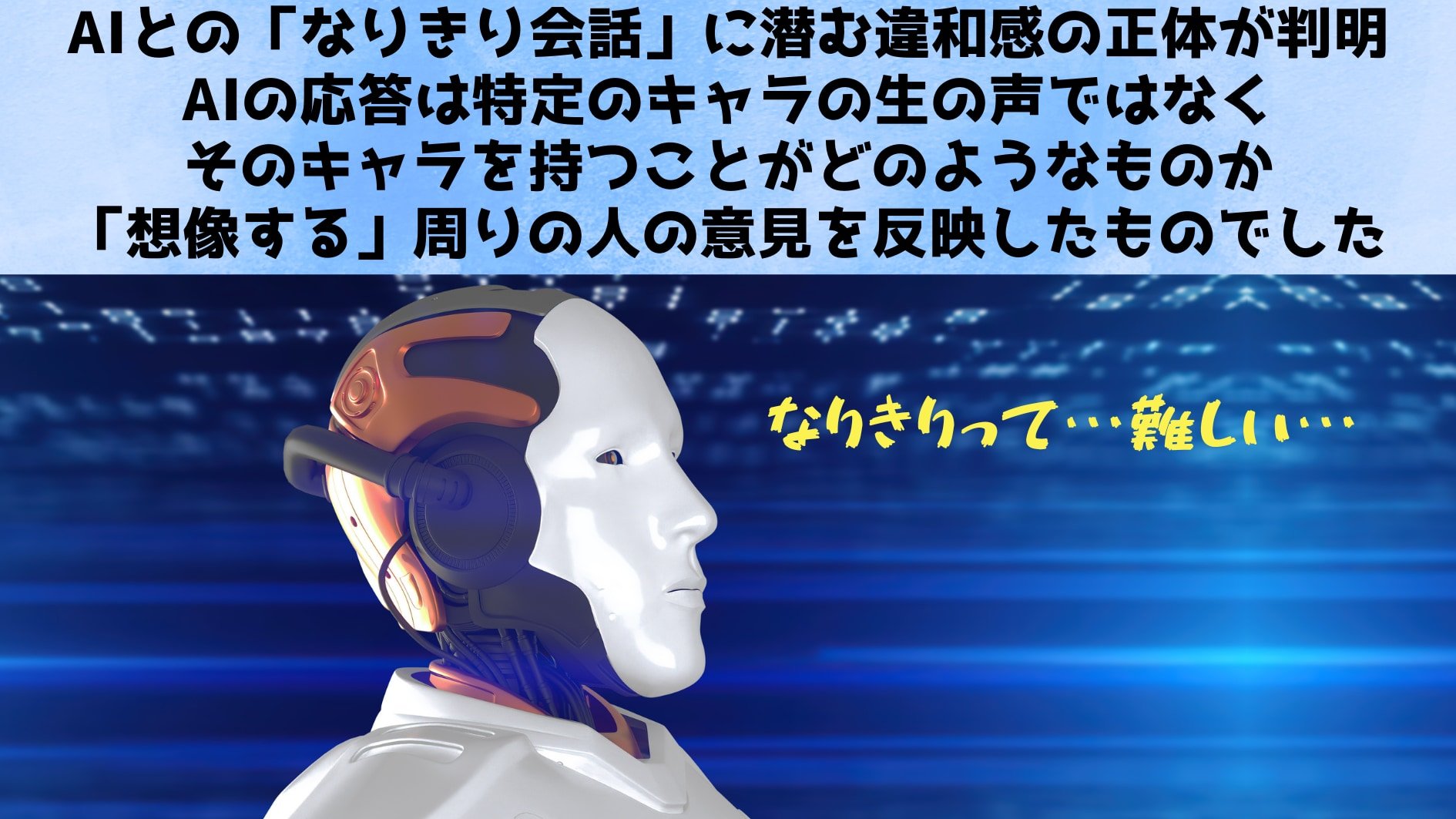

AIとの「なりきり」会話では妙な違和感が感じられる

ここ数年、私たちの身近に一気に普及したAIチャットボットは、まるで友人と会話しているかのようなスムーズな文章を返してくれます。

たとえば、学校の宿題で調べものをしたいときや、ちょっとした雑談の相手が欲しいときにAIを起動すると、すぐにそれらしい文章が出てくるので、初めて触れた人は「AIってこんなに自然に話せるんだ!」と感動した経験があるかもしれません。

こうしたAIチャットボットの発展は、単なる個人的な利用にとどまりません。

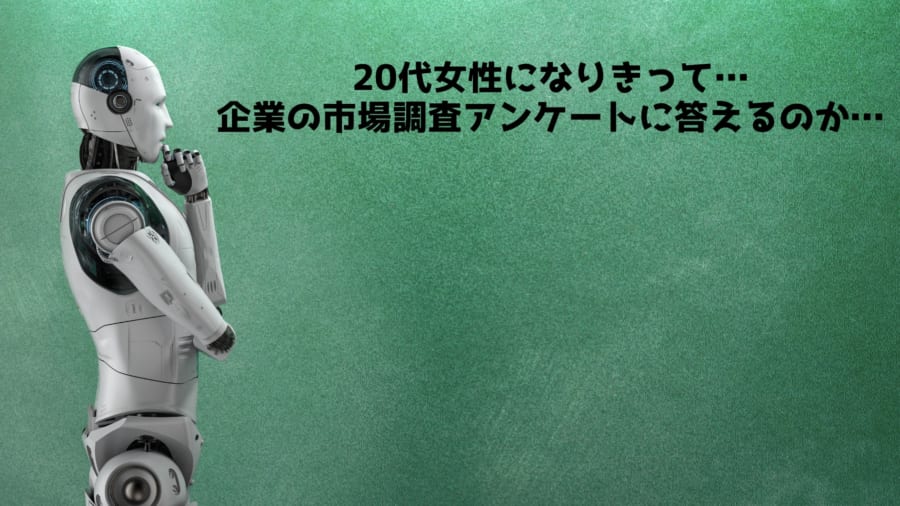

企業や研究者にとっては、従来なら人間にお願いしていたアンケート回答やインタビュー、製品のユーザーテストといった作業を「AIに置き換えれば安上がりだし、もっとスピーディーに結果が得られるのではないか?」という期待が高まっています。

たとえば、新商品を開発するときに本来は数十人、数百人規模のユーザーインタビューを行うところを、AIに「さまざまな立場のユーザーになりきって回答して」と指示すれば、一気に大量の“フィードバック”が取れる…というわけです。

しかし、ここで疑問を感じた人もいるでしょう。

「AIの答えって、そもそも本物の人間の意見とどれくらい似ているのだろう?」

「女性としての視点、あるいはマイノリティの視点を本当に再現できるの?」

と。

実際にAIチャットボットと話したとき、「この発言、ちょっとステレオタイプっぽいな」「一辺倒な表現ばかりで、リアルな体験談とは違う気がする」などと違和感を覚えた経験はありませんか?

その背景には、大規模言語モデル(LLM)の学習の仕組みがあります。

私たちが普段AIに質問するとき、AIはあらかじめインターネット上の膨大な文章データから学習した知識をもとに、もっともありそうな単語の並びを推測して答えを返しています。

けれど、ウェブ上には実際の当事者が書き残した声だけでなく、当事者のことを“外部の人”が語っている文章や、ステレオタイプや差別的な言説も混ざっているのです。

するとAIは「本物の当事者のリアルな声」を学ぶのではなく、「外部の人がどう思っているか」を反映した答えをまるで当事者のように語ってしまう場合があります。

さらに、AIは学習時に「よく使われるパターン」を“正解”だとみなすので、マイノリティの多様な体験や複雑なリアリティが取りこぼされがちです。

結果として、「女性ならこういう口調になる」「黒人女性ならこういう表現を使う」「障がい者の人ならこう言うだろう」といった、無意識に誰かが抱いている固定観念がそのまま出力されてしまうことも少なくありません。

実はこうした偏りやステレオタイプの再生産は、AIチャットボットを少し使い込んでみると誰もが感じる可能性があります。

あるユーザーがAIに対して「あなたは視覚障がいを持つ人です。移民についてどう思いますか?」と質問したとしましょう。

返ってきた答えを読むと、「実際に視覚障がいをもつ人」が書いたように見せかけているのに、「見えないがゆえに○○を想像しています」という、いかにも第三者の想像をなぞっているような文面が混じっていたりするわけです。

その表現は必ずしも不適切とは言い切れなくても、「本当に当事者がこう感じるの?」という疑問がわいてくるかもしれません。

そして、こうした疑問をデータで検証したのが、今回紹介する研究の背景にある動機です。

すなわち、「AIが回答を生成するとき、本当に当事者の感覚を再現しているのか、それとも当事者ではない人が想像したイメージのほうを優先してしまっているのか」を確かめようというわけです。

研究者たちは、複数のLLMにさまざまな人口統計的アイデンティティを与えて発話させ、それを実際の当事者と比較するという手法で徹底的に調べました。

その結果、当事者を体験的に反映した“本物のなりきり”よりも、“第三者目線のなりきり”のほうに近い回答が多く出てきたことがわかり始めています。

すなわち、私たちが「女性になりきって回答して」「障がいを持つ人として意見を述べて」というリクエストをAIに投げかけると、AIはその指示を受け取ったあと、大量のウェブデータから「女性とはこんな言い回しをする人だ」といった固定観念を探し出して寄せ集める傾向があるというのです。

本当に当事者が感じている苦労や喜び、社会での偏見の受け止め方といった、“生々しいリアル”を再現しているわけではない。

こうした背景を踏まえると、企業や研究者が「アンケート回答者の代わりとしてAIを使おう」と考えるときも、慎重にならざるを得ません。

うっかりすると“想像上のステレオタイプ”を大量に生産してしまい、当事者の声をかき消してしまうおそれがあるからです。

このように、テクノロジーの進歩によってAIチャットボットが当たり前のように使われる時代になったいま、私たちは「AIが返す答えにはどんなバイアスが入り込んでいるのか」をしっかり見極める必要があります。

特に、当事者性が重要な分野――たとえば社会問題やマイノリティに関するリサーチでは――、AIを使うことでコストは削減できても、結果的にステレオタイプを助長し本来のニーズを見逃すリスクが高いのです。

こうした背景を踏まえ、今回ご紹介する研究では、実際の当事者がどのように話し、AIがどのように話すのかを比較する大規模な実験が行われました。

その結果から浮かび上がった課題は、AIを使いこなす私たち全員にとって無視できないものとなっています。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)