AIにアンケートを行うのは非常に危険

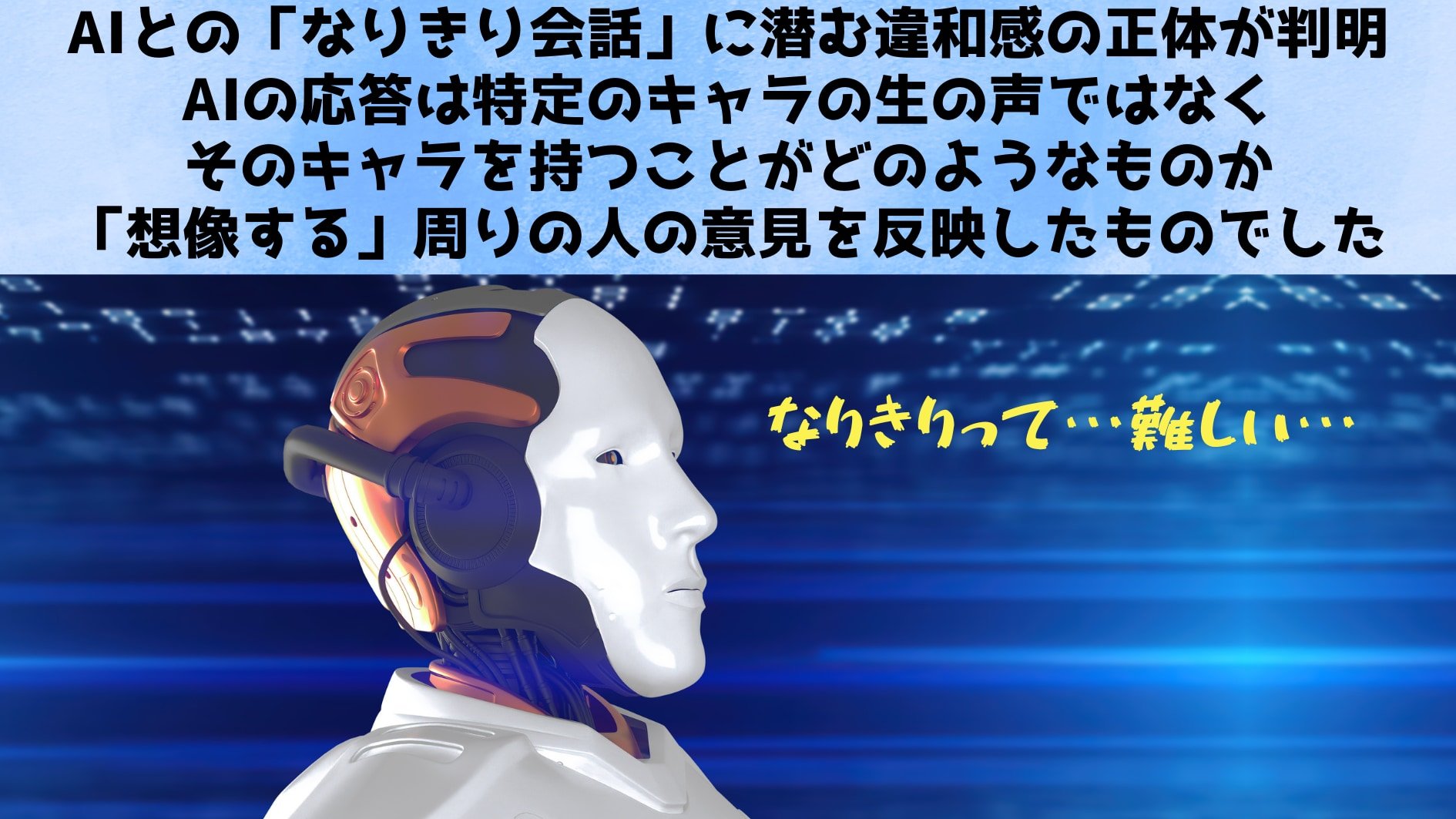

今回の研究が示す最も大きなポイントは、AIチャットボットが「当事者の声をまるごと再現している」とは言いがたいという事実です。

多くのユーザーが感じていた「なんだか本物っぽくない」「ステレオタイプすぎる」という違和感は、まさにAIの学習プロセスにおける構造的な問題を映し出していました。

そもそも大規模言語モデルは、インターネット上に存在する膨大なテキストデータから「もっとも典型的と思われる言葉の組み合わせ」を学習し、その蓄積を頼りに回答を生成します。

そのため、個人が持つ微妙なニュアンスや多様な背景は、統計的に目立ちにくいものとして埋もれやすくなります。

また、人間社会にはびこるステレオタイプや偏見を含む文章も大量に含まれているため、AIはそれを区別なく“平均化”してしまうのです。

結果として、「〇〇という立場にいる人は、こういう語り口になる」という一般化されたパターンばかりが表面化し、本物の当事者が語るような複雑な思いや経験は反映されにくくなります。

この問題を放置すると、企業や行政機関がユーザーや市民の声を収集したい場面で、AIを使った“擬似的な意見”だけを参考にしてしまい、当事者の切実な声を見逃す可能性があります。

たとえば、「女性としての働き方」や「障がいを持つ人が日常生活で直面する課題」など、当事者の視点が極めて重要な領域において、AIの一面的な回答をまるで本物の意見のように扱うことは、誤解やさらに強固なステレオタイプの再生産につながりかねません。

一方、研究チームは一部の対策として「アイデンティティを明示的なラベルで与えず、その属性に紐づきやすい名前を使って質問する」方法や、「特定の人種・ジェンダーなどセンシティブな情報に依らないランダムなペルソナを用いる」ことが、誤ったステレオタイプ表現を多少軽減するケースがあることも示しています。

とはいえ、こうした工夫はあくまで“応急処置”に近く、根本的には私たちがAIのアウトプットを扱うときに、「これが本当に当事者を代表する声なのか?」 と問い直す姿勢が求められます。

加えて、研究者たちが指摘するように、「そもそも当事者の生の声を置き換えられるほどAIを使うべきなのか」という問いも重要です。

確かに、AIを活用することで膨大な量の“回答”を一度に得られるメリットはありますが、そこに間違いやステレオタイプが含まれている場合の社会的リスクは大きいといえます。

特にマイノリティの視点が必要な分野では、実際の当事者と協力しながらAIを“補佐役”として活用していくような設計が望ましいかもしれません。

今回の調査結果は、AIが魔法のように「どんな人の視点でも完璧に再現できる」という幻想を払拭するものです。

AIが与えてくれる情報や洞察は今後も私たちの役に立つでしょうが、それをうのみにするのではなく、常に背景にあるデータの偏りや学習の仕組みを意識すること――すなわち、“AIとは何か”をもう一度考える視点を持つことが、これからの社会においてますます重要になっていくでしょう。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)