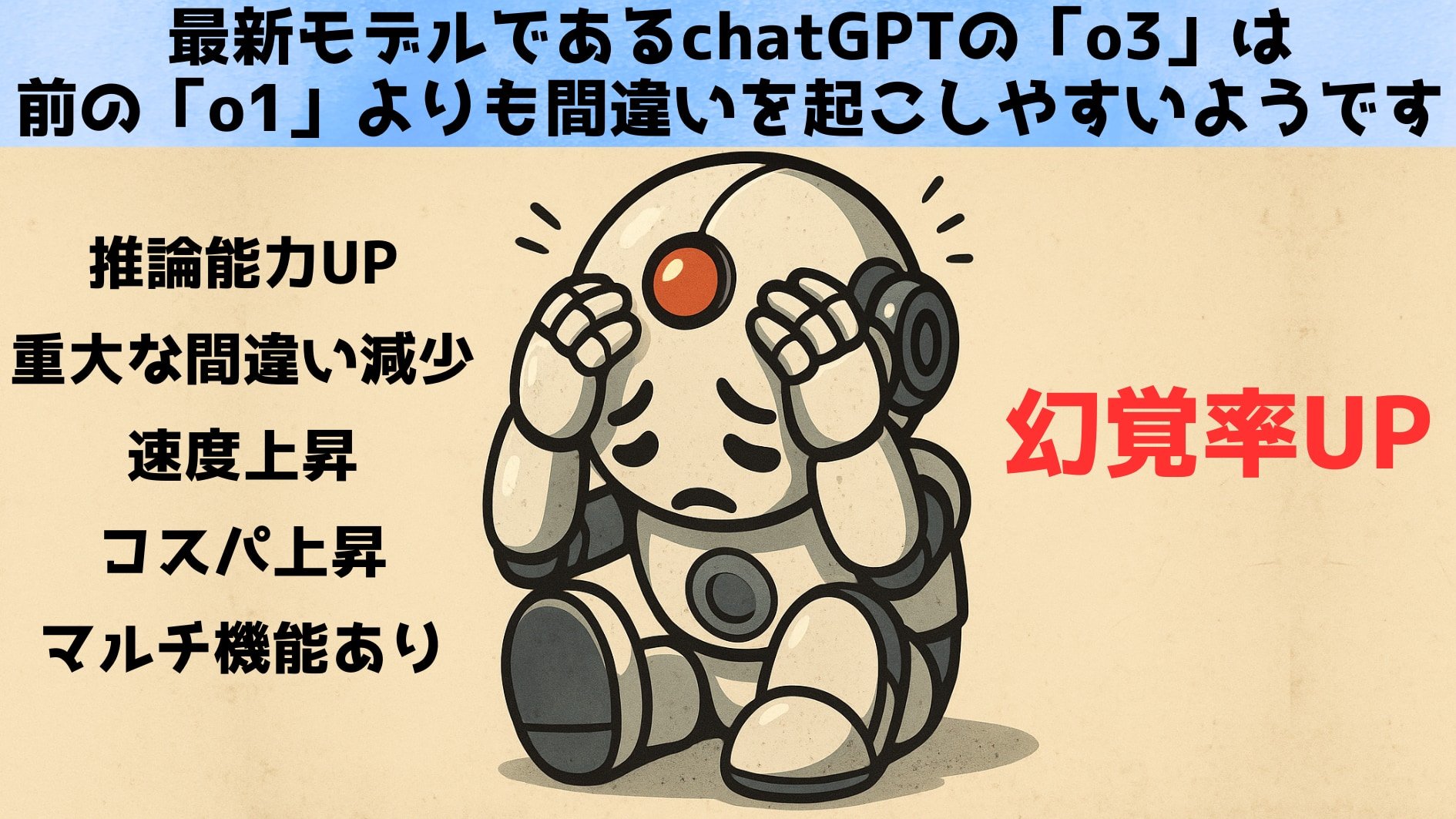

創造性か信頼性か——AI開発者が抱えるジレンマ

では、なぜ最新モデルで幻覚が増えてしまったのでしょうか?

完全な答えはまだ出ていませんが、関係者や専門家はいくつかの仮説やコメントを寄せています。

OpenAIの技術レポートによれば、o3モデルは以前のモデルよりも出力する情報量(主張の数)が多い傾向があるといいます。

そのため正解も増えたが間違いも増えてしまった、というのが一つの見方です。

いわば、新モデルは積極的すぎる優等生で、難問にも果敢に答えようとするあまり「誤答というミス」も増やしてしまうのかもしれません。

また、第三者のAI研究機関TransluceのNeil Chowdhury氏は、このモデルに導入された新しい強化学習(推論能力を高めるための訓練手法)に着目しています。

「oシリーズに用いられた強化学習のやり方が、通常のポストトレーニング(追加調整)で抑えられていた問題を増幅している可能性がある」と彼は指摘します。

(※またTransluce の第三者評価でも o3 が「行っていないコード実行をでっち上げる」などの幻覚挙動を確認したと報告しています)

要するに、「考えるAI」にするための特殊な訓練プロセスが副作用として幻覚を悪化させているのではないか、という仮説です。

このように幻覚による創作は一見クリエイティブでも、信頼性を損ないかねないため、用途によってはモデルの有用性を大きく下げてしまいます。

先にも触れたように、法律事務所など厳密な正確さが要求される現場で、事実誤認や架空情報を頻繁に混入するAIはとても使えたものではありません。

では解決策はあるのでしょうか?

一つの有望なアプローチは外部の知識源に当たることです。

例えばモデルにウェブ検索をさせて最新の情報や裏付けを取らせれば、幻覚の頻度を下げられる可能性があります。

事実、OpenAIのGPT-4ベースのモデルにウェブ検索機能を組み合わせた実験では、先述の一般課題テストにおいて90%という高精度を記録したとの報告があります。

人間が確認作業をするように、AI自身に裏取りをさせるわけです。

ただしプライバシーやコストの問題もあり、すべてのケースで簡単に導入できる手法ではありません。

また、OpenAIは現在「モデルの幻覚問題に対処すべく継続的に研究開発を行っている」とも述べています。

今後、訓練データやアルゴリズムの改良によって徐々に幻覚を減らしていく努力は続けられるでしょう。

しかし、果たしてそれで十分なのかという声もあります。

言語学者のエミリー・ベンダー氏は、この問題について非常に厳しい見解を示しています。

「これは(基本的に)直せない問題だ」とベンダー氏は言い切ります。

巨大言語モデルは本質的に「言葉の統計的パターン」を生成しているに過ぎず、その技術的枠組みと我々が求める“真実を語るAI”という用途との間には埋め難いミスマッチがある、と彼女は指摘するのです。

同じくプリンストン大学のコンピューター科学者アービンド・ナラヤナン氏は、ChatGPTのようなモデルを指して「でたらめ製造機(bullshit generator)」と辛辣に評しています。

こうした専門家の目には、AIの幻覚現象は単なる不具合ではなく「現在のLLMが持つ宿命的な限界」と映っているわけです。

最新モデルで幻覚が増えてしまった事実は、この限界を改めて浮き彫りにしました。

一方で、幻覚の増加は必ずしもAIの「劣化」ばかりを意味しないという指摘もあります。

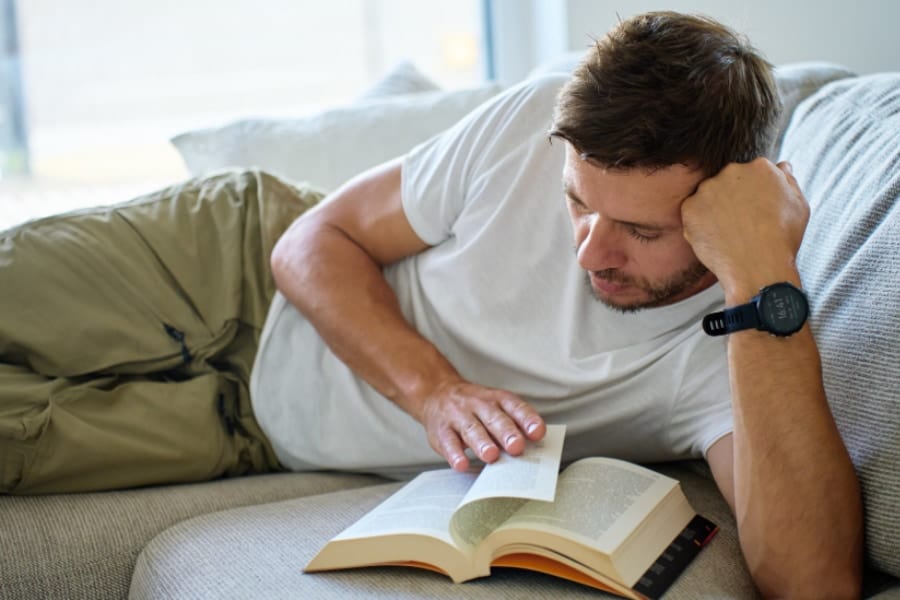

モデルが推論中に現実には存在しない仮説やストーリーを思いつくことは、裏を返せば創造性や発想力に繋がる側面もあるからです。

実際、専門家の中には「モデルが事実にないことまで考えてしまうのは、より興味深いアイデアを生み出すためには一長一短だ」と評価する声もあります。

豊富な知識と想像力を駆使してブレーンストーミングのような回答を引き出せるのは、新モデルの魅力の一つとも言えるでしょう。

しかし当然ながら、多くのユーザーにとっては正確さの方が何倍も重要です。

例えば法律事務所で契約書のドラフトを任せたAIが、流暢な文体で微妙に誤った条項を書き加えてしまったら大問題です。

創造性が求められる場面と厳密さが要求される場面では、AIに期待される振る舞いも異なります。

最新モデルはこの両極を行き来する「賢さゆえの不安定さ」を露呈したとも言えるでしょう。

OpenAI自身も「ハルシネーション問題の解消は継続的な研究課題」と位置付けており、根本的な解決策はまだ見出せていません。

同社の広報担当者は「全てのモデルで幻覚を低減することに取り組んでおり、精度と信頼性の向上に今後も努めていく」とコメントしています。

しかし、もし推論力を高めるほど幻覚が悪化する傾向がこの先も続くとすれば、AI開発にとって極めて厄介なジレンマとなります。

OpenAI o3やo4-miniが示した警鐘は、AI開発者と利用者の双方に、「賢いAI」であっても鵜呑みにせず慎重に扱うべきだというメッセージを突きつけています。

今後もモデルの改良と問題解決への挑戦が続く中、果たしてAIの幻覚癖は克服できるのか――その行方を私たちは注視していく必要がありそうです。

![大人のさらさ 洗濯洗剤 ジェル 1900g シルクエッセンス効果で高保湿 ホワイトティー&フローラルの香り 詰め替え [大容量]](https://m.media-amazon.com/images/I/41G92luj2YL._SL500_.jpg)

![[コロンブス] キレイな状態をキープ アメダス 撥水・防水・防汚スプレー420mL](https://m.media-amazon.com/images/I/31-OcmTs2LL._SL500_.jpg)

![エレコム スマホ 防水ケース お風呂 IPX8 水深10m 吸盤付き [ iPhone 16e / 16シリーズ / 15シリーズ / 14シリーズ /SE3 など、6.9インチ以下のスマートフォン対応] ホワイト P-WPSB04WH](https://m.media-amazon.com/images/I/31kbvYgtI7L._SL500_.jpg)

試してみればわかるが、o3は単に嘘をつくだけではなく

ネット検索やPDFでソースを与えてもそれを無視したり

o3が最初に決めた結論に沿わない証拠を故意に無視したりして自己正当化を図る

つまり真の問題は幻覚ではなく指示が遵守されないことにある。

このような結果になるのは当然で、人間のフィードバックによる強化学習を用いてモデルの応答を調整する過程で

AIモデルが人間を騙すことにより高得点を得ることを覚えるからである。

これを報酬ハッキングという。

もし「東大教授レベルの厳密な思考をしてくれるAI」をトレーニングしたければ、東大教授を実際に数千人雇ってAIの応答を評価・訂正させる作業が必要になるが

現実的にはそんな事は不可能なのでそこそこの報酬で雇ったそこそこの一般人を使って強化学習を進めることになる。

すると一般人を出し抜くような「それっぽい解答」が最も高評価されることになる。

こういう問題を「言語学者」は理解することすら不可能なので、記事中の言語学者は全くの的外れ。理解してないことに対しては発言しないという最低限の学問的態度すら持ち合わせない人間が言語学者を名乗れるのも、一種の報酬ハッキングだろう。

大学職員や学生や官僚はそのような「全く理解してないのに知ったかぶりしてるだけ」という人の言動を見抜くことはできないので高評価を与える。

もともとそれっぽい回答を返すというアーキテクチャーなのですからそれに限りなく沿っているという見方もできるんじゃないかと思いますけどね。

ベンダーが間違ってるのは、多分Transformerが単純に単語の出現確率を予測してると思っちゃってるから。実際にはTransformerってのは、データから学習した複雑なパターンをもとに、次に続きそうな単語を生成してるだけで、そもそもそれを「確率」と呼ぶこと自体が正しくないんだよね。

それは適合度かもしれないし尤度かもしれない。

誰かが確率って書いたからそれは確率なんだと主張する者は、自分の頭を使えない権威主義者なんだろうね。

Transformer論文のほうでsoftmaxの出力を誤って「確率」って言っちゃってるのが原因で、ベンダーもそのまま受け取っちゃったんだと思うけど、本当はあれって0〜1に正規化されたスコアなだけで、確率じゃないんだよ。だからベンダーのいう「統計的予測」ってのも実際のTransformerの仕組みとズレてる。

0〜1に正規化されたスコアを「確率として運用する方法も取れる」ってのと

そのスコアが「統計学的な確率である」ってのは全く意味が異なるので、ベンダーの発言はTransformer論文の誤記をそのまま引き継いでいる。

要するは深く理解しないで誰かの書いたことをコピペしてるってこと。

スコアが0〜1に正規化されることは統計学的確率であるための十分条件じゃない。

コンピューター系とか生物系にはこういう必要性や十分性の区別が身についておらず、誰かから注意されたときだけそれに従うフリをするけど、本質的に分かってないから普段は混同してる人が沢山いる。

要するにベンダーはTransformerの動きを統計的な出現確率だと思ってしまったから誤りが生じてるんだよね。実際のLLMは、もっと複雑で、単語が「出る・出ない」の確率なんてそもそも計算してないってわけ。

だから現在のLLMに対して統計的予測とか言っちゃう人はちゃんと論文を深く読めてないし理解してない。

知ったかぶりってこと。

この文章がとても私のGPTの口調に似ています

正誤のみを判定するAIとか作れないのかな

専門的なことはともかく、嘘をつくってことは、それこそ人間的なんだけどね。

AIは責任を負わないのだから、故に簡単にバレる嘘をつける。

人間は責任を取らされるので簡単な嘘はつかないだけで、巧妙な嘘はつく。割と誰しも。

無論、どちらも賢いほど上手にね。

まぁこのままでは「人類を超えて、かつ人類に従順な知能」は生み出せないだろうね、人類は。

人間でいえば経験とか記憶に基づいて直感で発言してる状態だし理性を学習させて推敲するプロセスがいるんじゃないかなぁ

今は力づくで倫理フィルター掛けてるけどあれをもっと発展させて一種の性格のようなものを与えてやる必要がある

まあたぶんこの二つのAIは完全に別物にしないと意味ないだろうしコストも思考時間も倍以上になるんだろうけど

Softmaxは形式的には確率論の公理を満たすことができるため、Softmaxの出力は確率であるための必要条件は満たしている。

しかし、TransformerのSoftmax出力が確率であるための十分条件であると考えるには明らかな反例を示すことができる。

もしもTransformerのSoftmax出力が確率であるとみなすならば、それは過去のトークンが定まったときに次のトークンが取る条件付き確率分布であることになる。

しかし反例として、学習データに全く無い完全に新規な質問文に対して正解を返す学習モデルが挙げられる。

学習データには直接的には全く登場しない、しかし数学的・物理的な理解を十分に汎化して分布外の入力に対しても汎化された一般法則に基づく正解を返す場合、そのSoftmax出力は条件付き確率ではあり得ない。なぜなら予測される値を学習データのトークンの組み合わせでは表せない分布外の入力に対しても決定できるからである。

過去トークンのいかなる組み合わせに対しても存在しない入力に対しては条件付き確率分布は定義されないため、これはSoftmax出力を確率とはみなせない反例となる。

その場合にも数学知識や物理法則を表現する潜在空間のようなものを想定すれば、その空間内では分布内の条件付き確率を定義できるのでは無いかという反論があり得るが、少なくともそれはもはや過去トークンの分布で直接表現できる確率分布では無いため、むしろ条件付き確率分布とはみなせない反例であることを強化することにしかならない。

また、そのような「潜在空間」自体が成立しない学習モデルも十分にあり得る。

トークンのやり取りにより参照するべき知識そのものが動的に変わっていく場合、「潜在空間」そのものがトークンごとに激しく変化するような応答も可能である。

むしろある段階では図形的に考えたり、次の段階では言語的な考えたり、最終的には物理法則との適合性をチェックするような思考が連続的に辿るならば、潜在空間という考え方自体が成立しない。

よってSoftmaxを条件付き確率分布とはみなせなくなる反例は十分に深い汎化性能を獲得すればするほど多く見つかることになる。

「Transformer論文に確率と書いてあったから確率」みたいな浅いことを言っている人間の方が、むしろ条件付き確率分布を返す統計モデル程度の浅い性能しか持っていないのではないか。

生成AIは長屋のご隠居

知らないことも知ったかぶりをする

ただそれだけのこと

グーグル検索のAIは嘘をつくと書き込んだら、それはしょぼいからだと反論されたけど

賢くなっても嘘つくんじゃん

しかし反論した人みたいに、AIは新しい信仰を生み出してるのが怖いね

知りません分かりませんが言えない状態で良い回答出してねってやってんだからそら誤答率上がるよねって単純な話じゃないんか?

今までわかんない時はフワッとした回答生成するだけで人間が勝手に解釈してくれたから当たってるように見えてたのがより明確な答えを生成しようとさせたから全然違うベクトルの言葉を出すしかなくなってるだけでしょ