■これまで、人の感性によって判断する演奏の違いを、コンピューターが認識・理解することはできなかった

■ピアノの演奏をデジタルデータ化してMIDIデータで取り込み、基準となる楽譜どおりの演奏データとの差分を用いて複数の演奏の間の類似性を数値化。この数値によって複数の演奏を比較できるようになる

■この技術は言語ではない方法での新しいコミュニケーションの基盤技術になると期待されている

人工知能と音楽が…出会った〜(cv. 下条アトム)

筑波大学システム情報系山際伸一准教授、大阪大学産業科学研究所河原吉伸准教授らの研究グループは、人の感じる音楽の感性を数値化し、演奏の類似性を数値で比較できる人工知能技術を開発しました。

http://www.tsukuba.ac.jp/attention-research/p201904101400.html

コンピューターに演奏の違いを認識させ数値化する人工知能を開発

コンクール評価などの音楽性の判断は通常、アーティキュレーション、デュナーミング(強弱法)、フレージング(フレーズの切り方)とよばれる3つの要素の違いに基づいて、経験的な人の感性によって行われます。しかしこの判断基準を数値化できれば、感性のデジタル化が可能であると研究グループは考えました。

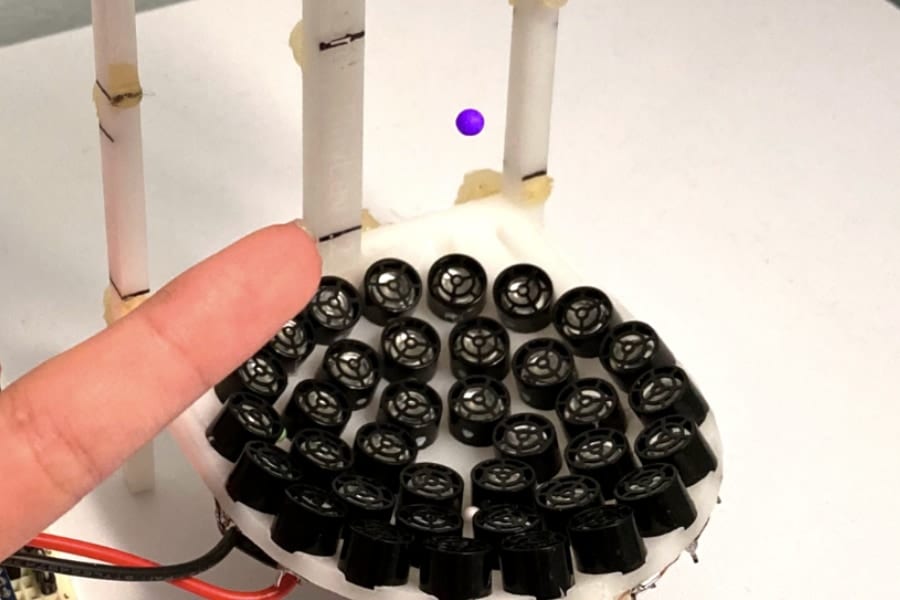

研究グループは、まずピアノの演奏について注目し、その演奏の音楽表現を人工知能で認識させました。国際的な規格MIDIによってデジタル化された演奏データには、音符の打鍵タイミング、打鍵の強さ、音の長さといった情報が時間軸で記録されます。

数値の比較は、楽譜通りに作った「基準演奏MIDIデータ」を準備し、これと演奏者の「ユーザー演奏MIDIデータ」 の打鍵タイミングの時間差から音楽性の類似の程度を表し、両者を比較することができます。

具体的には、上の図のように複数のユーザーの演奏の3つの要素を数値化します。それにより、ユーザー同士の類似性を比較して、音楽感性が似ているかどうか判断できるのです。例えばユーザー1とユーザー3の音楽性は他のユーザーよりも似ていることがわかります。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)