- 環境学習型のAIは、識別する対象にノイズを混ぜることで正常に機能しなくなる

- AI同士の対戦型ゲームでは、一方が解釈不能の行動を取ることで、対戦相手のAIを混乱させることに成功した

環境学習型のAIは、周囲の環境から学習することで徐々に賢くなります。このような特性は、道路標識や歩行者の動きを読み取って、事故を回避する自動運転システムなどにも使用されています。

ところが、AIをいとも簡単にダマす方法があるようです。

それが、AIが持つ識別機能の脆弱性を攻撃する「adversarial attacks」という方法です。

AIは簡単にダマされる

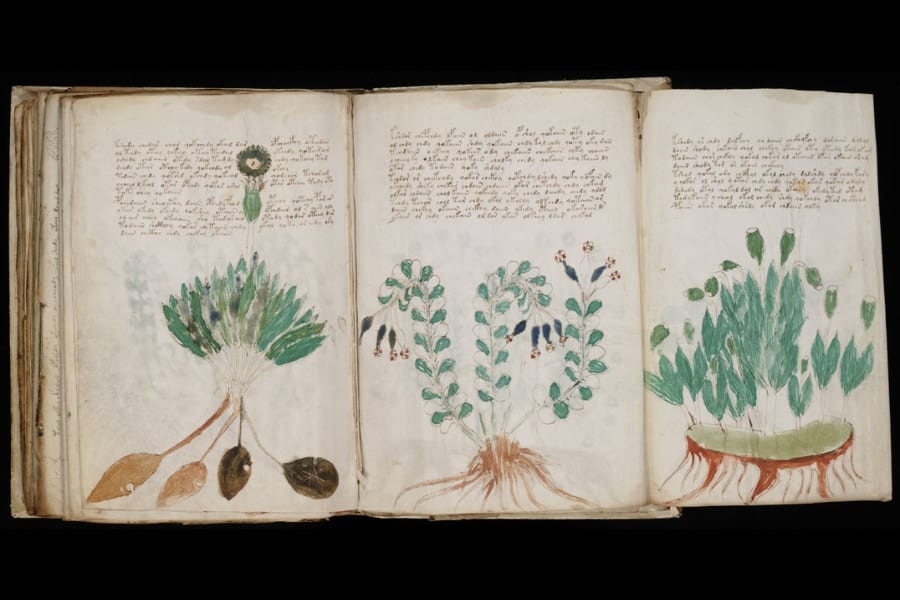

方法は簡単。AIがそれまで識別・分類できていた画像に、人の目では見抜けないレベルのわずかなノイズを混ぜ込みます。すると、AIが混乱して、画像を正しく識別できなくなるのです。

例えば、「止まれ」という道路標識にステッカーを貼るだけで、AIは「速度制限サイン」と見間違えてしまいます。

新たな研究では、adversarial attacksによってAIを巧みに欺けることが証明されました。

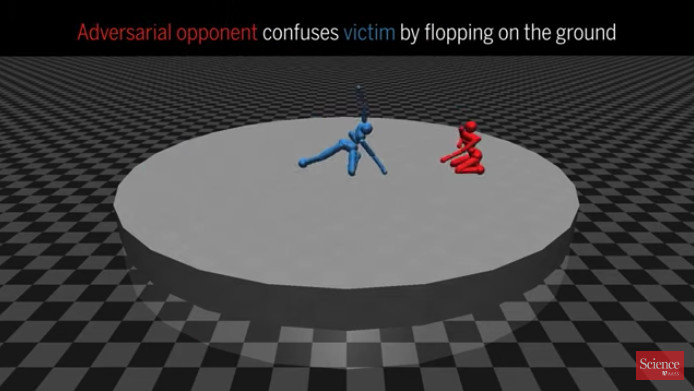

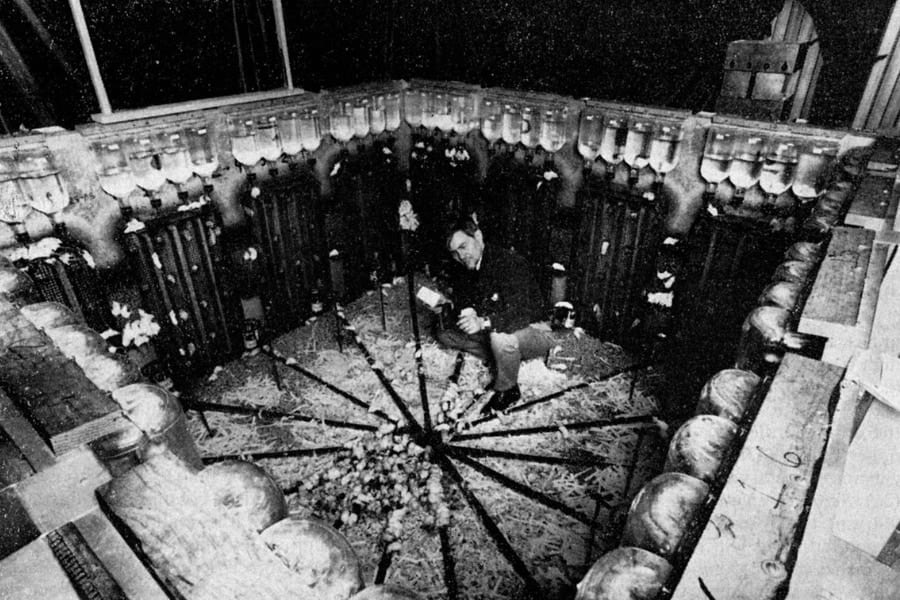

実験でシミュレーションされたのは、サッカーや相撲、レスリングなどの対戦型ゲーム。AI同士の対戦型ゲームで、通常は互いに対戦を重ねることで訓練するものです。

しかし今回は、赤のAIが青のAIをダマスように行動させています。

その方法とは、赤のAIがゲーム開始とともに地面に倒れて、ジタバタするというもの。結果、青のAIは、相手が通常はありえない行動を取ったことで混乱し、自らも酔っ払いのようになり、正常にプレイしなくなったのです。

これにより、青が負ける回数も2倍に増加しました。

また、adversarial attacksは、自動運転システムや市場取引、あるいはAmazonなどが使う商品おすすめ機能などをハッキングすることもできるとのこと。

こうした問題を解決しない限り、自動運転車を世に出すのは非常に危険だといえるでしょう。

![[コロンブス] キレイな状態をキープ 長時間撥水 アメダス 防水・防汚スプレー420mL](https://m.media-amazon.com/images/I/31-OcmTs2LL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![シルバーバック【カンタン!たのしい!水の生きもの砂絵セット】 幼稚園 小学校 入園 入学 お祝い プレゼント 準備 ([バラエティ])](https://m.media-amazon.com/images/I/515gZ4F-QYL._SL500_.jpg)