人間が入力したテキストの意図をくみ取って画像生成してくれる

DALL·E2は入力された文章を理解し、画像をいくつか生成してくれます。

例えば、冒頭で挙げた「鉛筆で書かれた 馬に乗っている 宇宙飛行士」であれば、次の通りです。

「食料品を買っている テディベアの 浮世絵」であれば、こんな画像。

「粘土で作られた モンスターみたいな 一杯のスープ」のように、まったく統一感のないテキストからも画像を生成可能です。

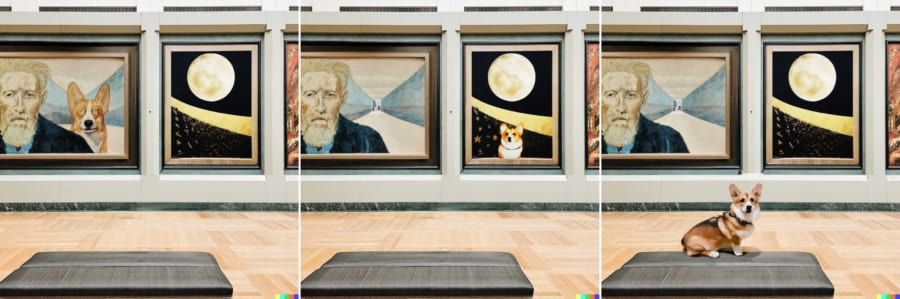

またDALL·E2は、既存の画像の影や反射、テクスチャを考慮しつつ、自然に編集してくれます。

例えば、下記の美術館の画像。

この絵のどこかに犬を追加したい場合、DALL·E2は追加する場所によって描写方法を調整し自然に馴染ませることができるのです。

上の画像を見ると分かる通り、絵画のタッチの違い、また絵画とリアルの違いを理解して、自然な形で犬を追加しています。

さらにDALL·E2は、オリジナル画像に似た(インスピレーションを受けた)画像も複数生成できます。

使い方によっては怒られそうなので、ちょっと注意が必要ですね。

ちなみに、暴力的・政治的・アダルト画像の生成には制限がかかっているとのこと。

DALL·E2は、今のところ研究者向けに提供されるので、私たちがすぐに利用できるわけではなさそうです。

とはいえ、「テキストからハイレベルな画像を生成できるAI」は既に存在しています。

もしかしたら今後、私たちの身の回りには、AIが生成した画像が溢れるのかもしれません。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)