「ChatGPTが生成した文章」に半数以上が騙される

ChatGPTなどのAIツールを用いるなら、誰でも簡単に文章を生成できます。

ネット上では毎日新しい記事が投稿されていますが、その筆者はAIかもしれないのです。

では人々は、AIが書いた文章と人間が書いた文章を見分けることができるのでしょうか?

Tooltester社は、この疑問を明らかにするため、あらゆる年齢層(成人)のアメリカ人1920人を対象にした調査を行いました。

彼らには様々なトピックで書かれた文章がランダムで提示され、それがAI(ChatGPT)によって生成されたものか、それとも人間(プロのライター)が作成したものか、もしくはAIによって生成され人間が編集したものか判断するよう求められました。

ちなみに参加者のうち57.1%は「生成AIを使ったことがある人」で、41.1%は「生成AIを知っているが使ったことはない人」、1.8%は「生成AIについて聞いたことがない人」でした。

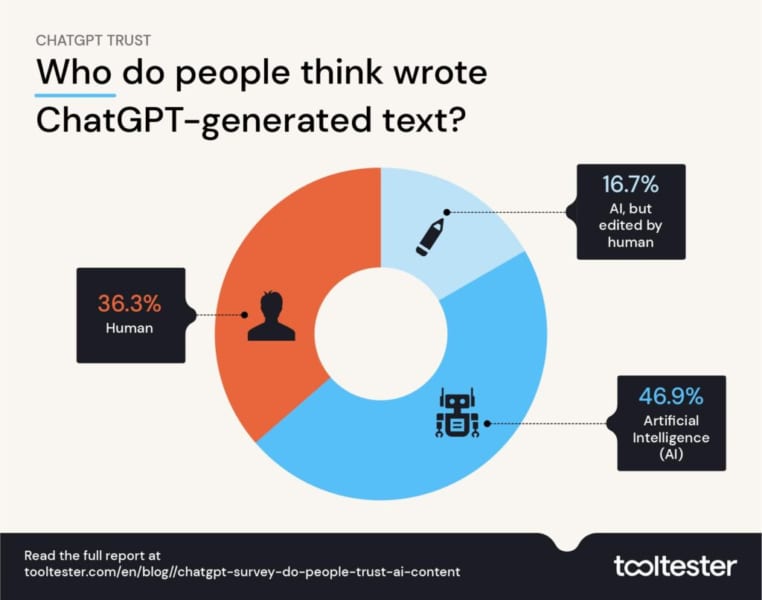

調査の結果、AIのみで作成された文章を正確に識別できたのは46.9%でした。

さらに掘り下げると、ChatGPTの文章を読んだ人のうち、36.3%は「これは人間が書いたものだ」と感じ、16.7%の人は「AIの文章を人間が編集した」と感じていました。

つまり半数以上(53%)は、完全なAIコンテンツに対して、どこかの時点で人間が関与していると考えたのです。

では、特にどんな人々が騙されやすかったのでしょうか?

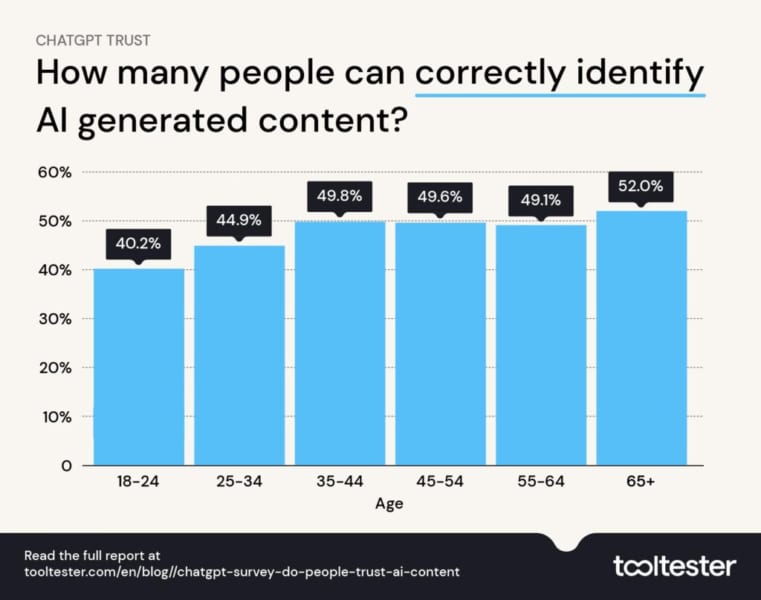

上記のグラフで分かる通り、18~24歳がAIコンテンツの識別を最も不得意とし、正確に識別できたのは40.2%でした。

デジタルネイティブであるZ世代が最も騙されやすかったのです。

若くてテクノロジーに精通していたとしても、それ自体がAIの介入を見抜く助けにはならないのです。

対照的に、65歳以上がAIコンテンツを最も正しく識別できていました。

年配の人々は若い人よりも幅広い知識を持っており、これがAIコンテンツに潜む違和感を見つけるのに役立つのでしょう。

ちなみに、「生成AIを使ったことがある」と答えた人は、より正しく判断できる傾向にありましたが、それでも正解率は48%に留まりました。

AIツールに精通していたとしても、ChatGPTと人間を見分けるのは難しいようです。

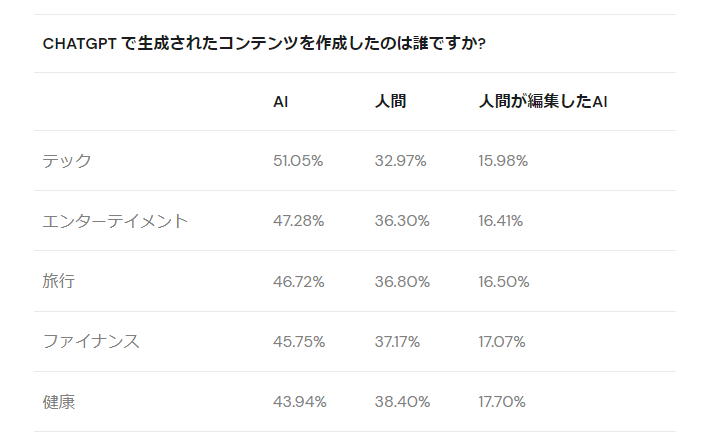

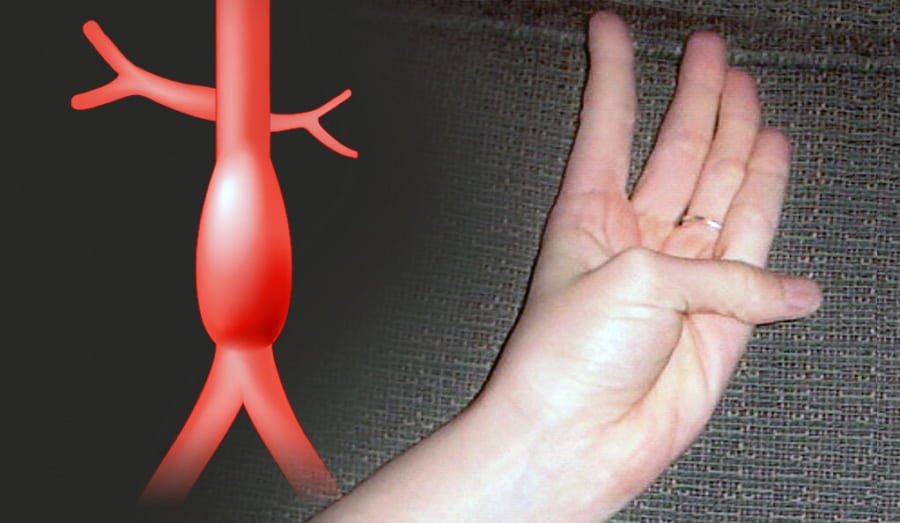

さらに、調査結果からすると、トピックによっても識別のしやすさに違いが生じると分かりました。

例えば、テクノロジー(テック)系のトピックでは、51.05%の人がAIの文章を正しく識別できましたが、健康のトピックでは、43.94%しか正しく識別できませんでした。

このことは、AI(ChatGPT)には得意分野があることを示しています。

AIは健康に関する記事をより説得力のあるものに仕上げることができるのです。

しかしこれは、非常に危険な傾向です。

責任感のないAIの言葉をまるで専門家のアドバイスのように感じる人は、自分の健康に悪影響を及ぼしかねないからです。

ChatGPTに自分がよく知る内容について質問したことがある人なら経験があるかもしれませんが、ChatGPTは情報が不足している内容に対して平然と嘘の回答を返してきます。

(ナゾロジースタッフが、本サイトについてChatGPTに質問したところ最も後に入社したライターが創設者だと回答されました)

今回の調査は、現時点で半数以上の人がAIと人間の文章を見分けられないことを示しており、今後技術の向上により、見分けられない人の割合はさらに増加していくと考えられます。

そのため調査で80.5%の人が同意しているように、もしAIに記事を書かせているなら、提供元はそのことを開示するべきでしょう。

ちなみにTooltester社は、今回の調査で用いられた文章の『サンプル(EXT)』を提示しています。

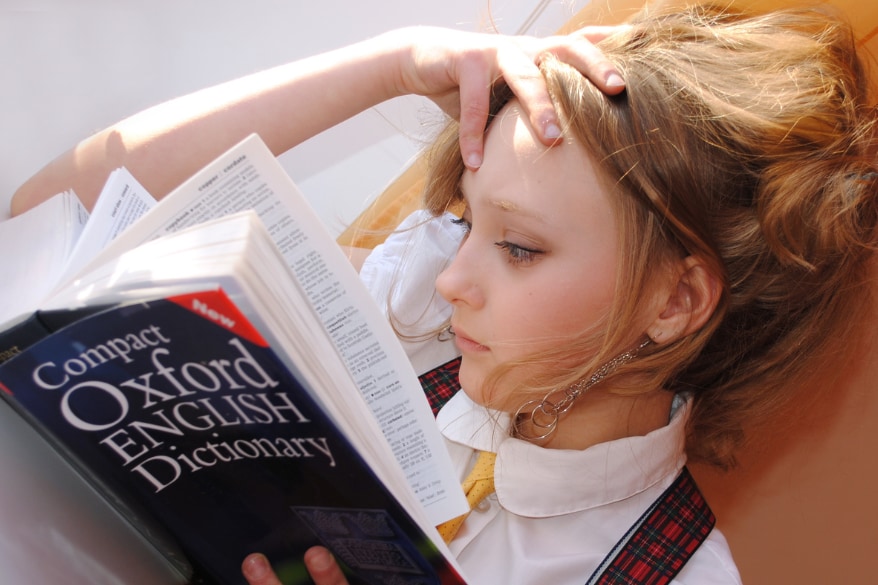

すべて英語ですが、理解できる人は自分がAIと人間を区別できるのか試してみるとよいでしょう。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)