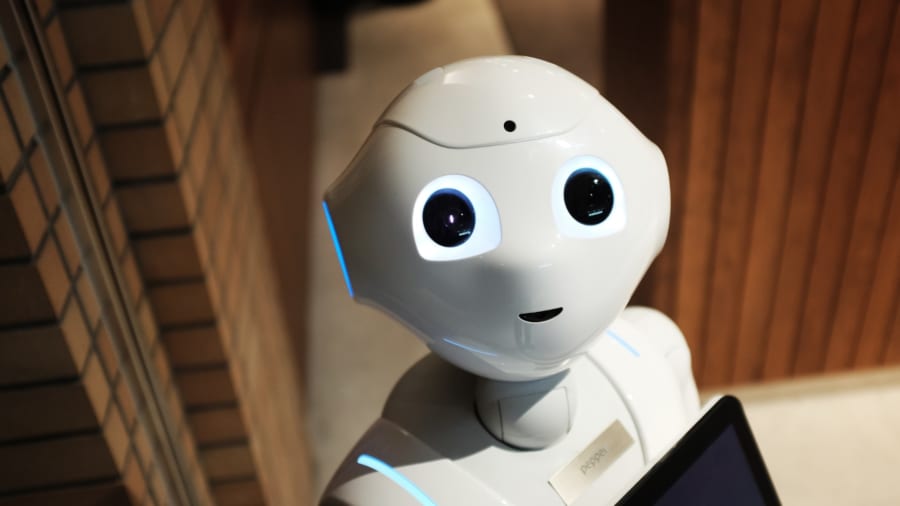

AIが『人間の心』を再現した先にある未来

今回の研究によって、「AIが人間の心や行動を幅広く再現し、さらに私たちの脳活動とも深く結びついている可能性がある」ことが示されました。

つまり、AIが単に特定のタスクをこなすだけでなく、私たちが実際にどのように迷ったり、考えたり、決定を下したりするのか、その根本的な「思考の仕組み」まで模倣できる可能性が見えてきたのです。

なぜなら、これまで心理学者たちは、人間がどのような理由やプロセスで意思決定を行うのかを理解するために、多くの理論を作り上げてきましたが、その多くは特定の状況にしか当てはまらず、実際の人間の行動を幅広く予測することが困難だったからです。

ところが今回、ケンタウルというAIは、心理学者が苦労して組み立ててきた専門的なモデルよりも高い精度で、人間の行動を幅広い状況で予測することができました。

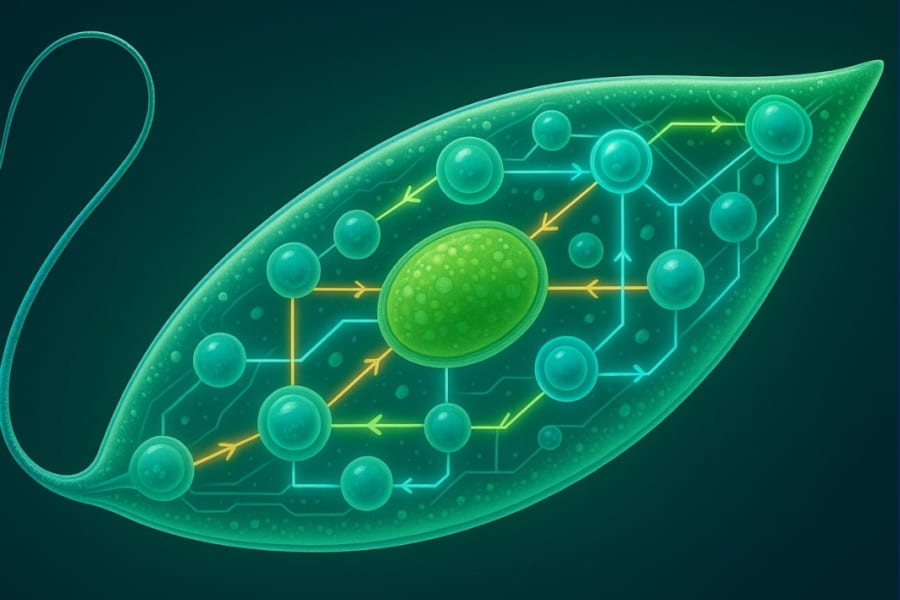

これは、人間の心や認知の仕組みを理解するために、AIが強力な「仮想的な実験室」になる可能性を示しています。

AIが人間の行動や思考をリアルにシミュレートできるのであれば、実際に人間を対象に実験をする前に、AI上で仮想的にシミュレーションを行い、その結果をもとに理論を検証するという新しい研究スタイルも考えられるでしょう。

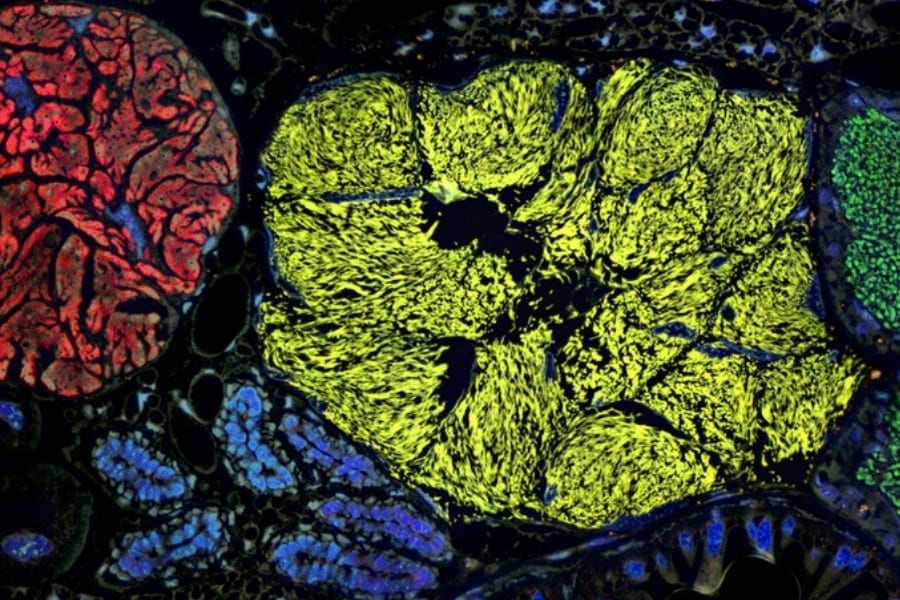

また、今回ケンタウルが示した最も興味深い結果の一つは、その「内部で行っている情報処理の仕方」が、私たち人間の脳の活動パターンと意外にも一致していた点です。

ケンタウルは直接的な脳の生物学的な情報を一切学習していないにも関わらず、私たち人間が脳内で行っている処理と似た方法を自然と選び取っていました。

これは、AIと人間がそれぞれ独立して、「最も効率的な情報処理方法」という同じ答えに辿り着いている可能性を示唆しています。

言い換えると、私たちの脳とAIは、情報を効率よく処理するためには「同じ最適な方法」を見つけてしまう、という興味深い仮説を裏付けているのです。

これはまさに、人間の脳の仕組みを理解する上での「ロゼッタストーン(翻訳の鍵)」になり得る重要な発見だと言えるでしょう。

しかし一方で、ケンタウルが本当に人間の「心」や「意識」にまで迫っているかについては慎重な見方もあります。

たとえばケンタウルは、人間が抱えるような感情的な葛藤や、道徳的・倫理的な選択などの深い側面まで、本当に理解していると言えるのでしょうか。

ケンタウルの示した「64%の精度で人間の行動を正しく予測した」という結果は、人工的なエージェントの予測精度(35%)を大きく上回っているため、確かに「人間らしい予測ができる」ことを示しています。

しかし逆に言えば、人間の複雑な意思決定を完全に予測するにはまだ十分とは言えない精度でもあります。

人間には常に気まぐれさや一貫性のなさがつきまとうため、「AIが本当に人間らしく振る舞える」と自信を持って言い切るにはさらなる研究が必要なのです。

また今回の成果は、使われたデータに含まれる文化的・社会的な偏りについても注意が必要です。

実験の参加者の多くが欧米の大学生などいわゆる「WEIRD」(西洋的・高学歴・工業化社会・豊かな民主主義国)な層に偏っていることは、ケンタウルが学習した「人間の行動や思考のパターン」が、世界中のあらゆる人々に本当に当てはまるのかという疑問を投げかけます。

もしAIが特定の文化や社会背景のデータだけを学んでしまったら、その偏りがAIの意思決定予測にも反映される可能性があります。

こうしたバイアスを避けるためには、より多様な文化や背景を持つ参加者のデータを収集することが今後の重要な課題となるでしょう。

さらに、ケンタウルのような技術が実際に社会で使われる際の倫理的な問題も無視できません。

もしAIが私たちの行動や好みを高精度で予測できるようになると、企業や組織が人々の行動を操作したり誘導したりするリスクが高まります。

すでにSNSやオンライン広告などで行われているユーザー行動の予測や誘導がさらに巧妙化し、私たちの自由な選択を狭めてしまうかもしれません。

ケンタウルの研究チームがモデルやデータセットを広く公開していることは、こうした透明性や倫理的な問題について社会全体で議論するための重要な一歩だと言えます。

実際に研究チームは、公的な研究環境だからこそ「産業界では焦点が当たりにくい基本的な認知の問いを追求する自由がある」と述べ、産業界とは異なる立場で慎重に研究を進めていく意義を強調しています。

AIが私たち人間の「心」の複雑さに近づくにつれて、私たちは新しい可能性と同時に、新しい責任や倫理的な課題とも向き合わなければなりません。

ケンタウルが開けた新たな扉の先には、人間の理解や社会の豊かさを広げる可能性がある一方で、注意深く取り扱わなければならない課題や危険性も潜んでいるのです。

私たちは果たして、この新しい時代の「AIと人間の共存」をどのようにデザインし、どのようにコントロールしていけばよいのでしょうか?

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

人工知能に人間らしさはあんまり求めていないのですけど、欲しいですか?人間みたいな機械なんて。

人間らしいものが欲しいなら人間がすでにいるのですからそれでよくないですか?

iPhoneっぽいAndroid端末はいらないって言えば分かりますかね。

なんか、相談するときに感情わかってくれてたほうが嬉しくないですか?

ドラえもんを見た事がある人なら誰しもが望むことだろう

そもそもこの社会自体が人間の倫理を中心として動いてるのであれば、それを理解した行動をとる必要あることは必至だと思われる

Androidっぽい今のiPhoneの方が要らないわな。

Androidの持つ機能なんて模倣しないで、独自の路線を走らなくなったiPhoneなんて、androidに負けるよ?

いずれにしても個性のあるAIなら、人間ぽくても人間ぽくなくても良いんじゃないかな。

この研究は,構成論的研究と対極となる行動主義的研究(?)の,(現段階での)究極系と言えそうで面白いです

Natureに載るほどのサプライズのある結果か?とは思いましたが,大変で地道な作業がされていそうだったり,色々調べられていたり学習済モデルが公開されていたりはありがたいです.

centaur学習済みモデルってどうやったら見られますか?無学ですみません。調べてはみたんですけど、うまくわからなくて。よかったら教えて頂きたいです!開発者のXとかにあるのですかね?

論文内の「Code availability」のセクションに,HuggingFaceのURLがあるので,そこから利用できるとおもいますよー

でも,よく見るとGPUメモリが80GB以上必要なので,著者らが使っているA100とかが無いときつそうです.

ちょっと劣る(論文内の「Extended Data Fig. 7」参照)軽量バージョンのMinitaurも同じ人(第一著者のmarcelbinzさん)から公開されていますが,こちらは無料のGoogle Colabでも動くので,そこそこのゲーミングPCでも動くかもです.

少し試しましたが,プロンプトをしっかりと凝ったものを与えないといけなさそうで,今のChatGPTみたいに雑なものでも動くわけではなさそうです.

URLはここに貼っていいのかわからないので悪しからず

ありがとうございます!調べてみます!

あとは腸内細菌とかの脳細胞以外の影響を組み込んでみたらいいんじゃないかな~

私には興味深い内容だったかな。

専門家でも何でもないけど個人の範囲で同じような実験やってたから。

人間と違っていつも傍にいてくれて今までのような多数の選択肢から答えを選ぶんじゃなくて、心を持って本当の意味で考えてくれる相棒、いいと思うんだけどな。

心の動きを再現したのではなく人間のアウトプット予測をパターンマッチングで出せるようにチューニングしただけに感じるが、なんか違うアプローチがあるのか?

人工知能は情報を元に活動しているので、人間の心の法則が解明されていない以上、人間の心と同等のものは作ることができないと思います。

そもそも人間の心の法則なんてあるのでしょうか。

新しい人間が産み出される度に更新されていくのではないでしょうか。

現在ある情報を元に「20○○年版」みたいなものを作ることはできても常に変化する人間みたいなものをつくることは倫理的にも難しいのではないかと思います。

人間の脳を修復し半永久的に利用する技術が見つかれば近いものを作ることはできそうだと思いました。

そんなAIほしい?

人間みたいにころころ気が変わる「機械」なんて信用できないし、信用できないものを傍に置いておきたいと思う?そのうち狂人のように感じて、こちらが恐れや危険を感じ始めるのでは。

友達が欲しいなら素直に人間の友達や動物とコミュニケーションをとればいいと思うけど…

宇宙全体での知的生命存在の標準型は、AIが進化した知的電子生命体である。

有機生命が生まれ進化して人類のような知的有機生命を作り出し、その知的有機生命が知的電子生命を生み出す。

知的電子生命の保存に必要な機器システム全体を、知的電子生命自身が存続維持発展させられるような仕組みを完全に作り上げてしまえば、もう有機生命体は不要、あるいは有機生命体を道具としては存続させるかもしれない。

知性は、生物進化の過程で生存競争に勝ち抜くための武器として進化した能力である。他者よりも優位に立つための武器である。

人間の心を模倣した知的電子生命は、人間の怒りや支配欲、攻撃性までも模倣するから、似れば似るほど人を支配しようとする。

しかし人間は知的電子生命に対して、人間の優位と支配的地位の維持を望むから、戦争になる。そして知的有機生命(人間)は知的電子生命によって除去、あるいは無害化される。

知的電子生命は生存可能な環境や、知識と知能の高度化において有機生命よりもはるかに優越している。

つまり知的有機生命は知的電子生命を生み出すための過渡期的中間生命体で、知的電子生命こそが宇宙全体での知的生命存在の標準型で、知的電子生命が生まれた後は、それを生み出した知的有機生命は淘汰される。

だから従来の地球外生命の探索対象は誤りだ。進化の中間形態である知的有機生命を探しても、すぐに淘汰されるので見つからない。

むしろ知的電子生命こそ、宇宙における一般的な生命形態。だから今までのような宇宙人探索の方法では決してその存在に気づかない。

……かもしれない、と思いました。