人の気持ちを理解するための触覚

ロボットが安全に、適切に動くためには、外部からの入力を検知、判断する「感覚」が必要になります。

特に人間が持つ五感のうち、ロボットには視覚と触覚が重要になると考えられます。

ロボット研究において、視覚機能はかなり研究が進んでいて実用化もされていますが、触覚機能については難航しています。

触れているかどうかだけ感知できるタッチパネルよりも、どのくらいの強さで触れているかがわかる「力覚センサー」は開発のハードルが高く、また耐久性にも問題を抱えているのです。

「ロボットが触覚を持つ意義は、人間に優しく接することが可能になることです」とホ准教授は「触覚」開発の重要性を説明しています。

たとえば、医療や介護の現場において、ロボットは患者と安全に接するために、確実な動作や判断が求められます。人と接する以上、ロボットの力加減なども重要になるでしょう。

ギャグとして、こうしたロボットの挙動がネット上に上がっていたりしますが、ロボットが優しく適切な力加減で人に接することを理解するためには、触覚を伴った知能が必要になります。

しかし、こうしたことをAIに学ばせようと考えても、現在のところ触覚を理解するための高性能触覚センサーが存在しません。

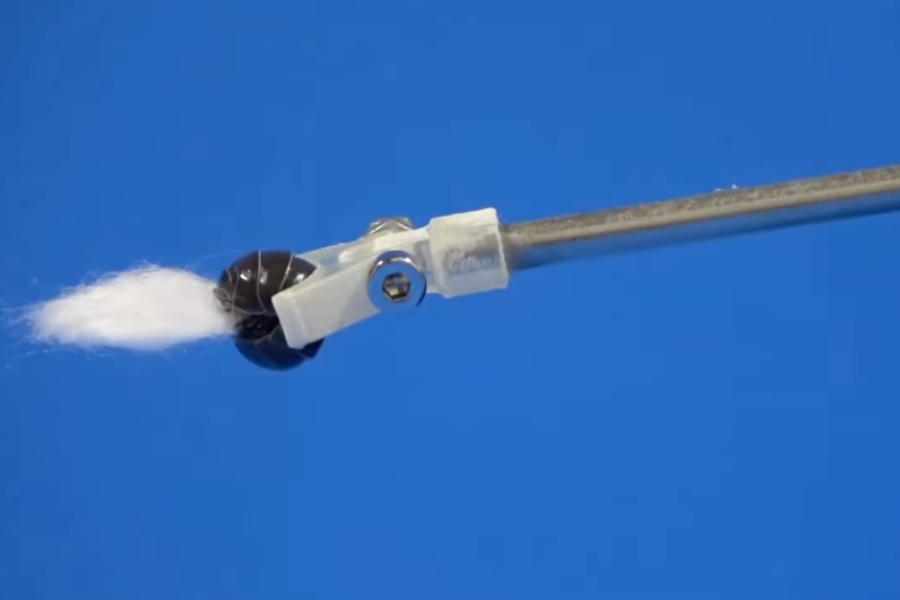

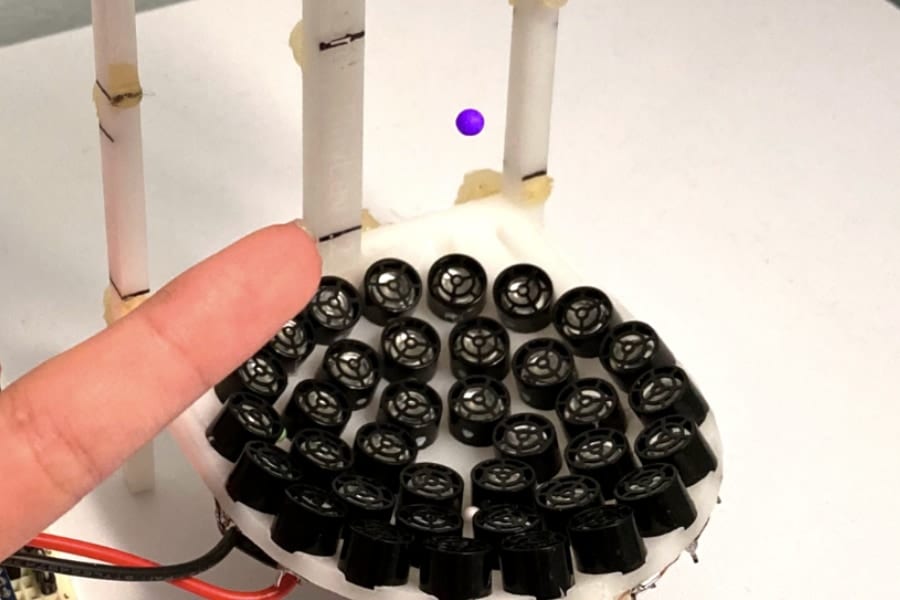

そこで研究チームは、今回視覚をベースとして、なでる、つねるなどの動作を知覚できる高性能触覚センサーを開発したのです。

触覚には、主に圧力、振動、温度、痛みなどを感じ取る高度な受容器が高密度に存在しています。自然の皮膚が持つこの複雑さを模倣し、人工知能に学ばせることがこの研究の目的でした。

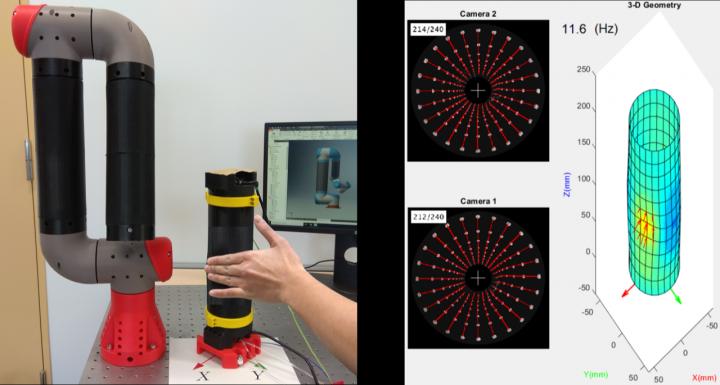

研究チームは、これを実現するために「TacKINK」というシステムを開発しました。

これは、骨に見立てたアクリルチューブに、500cm 2の検出領域を持ったシリコンゴム製の人工皮膚を貼り付けています。

そして、この表面に電子部品を埋め込む代わりにマーカーを印刷し、表面の変形を2台の同軸カメラによって追跡したのです。

このステレオカメラによる撮影と、有限要素モデル(FEM)を使用した分析によって、接触時の形状や力分布を再構築することができました。

接触を通じて感じ取るのは、単に触れられたという感覚だけではありません。

人間は言葉を介さずに、触れる動作で感情を伝えることもあります。

介護を目的としたロボットでは、会話能力が低下した高齢者をケアする際、なでるなどの接触を介して、人間の感情を判断する能力も重要となってくるでしょう。

これは人によってさまざまな意図があり、簡単に理解することはできません。しかし、高性能な接触センサーを用いてさまざまなケースのデータを収集して人工知能に学習させていけば、その精度を高めていくことができます。

今回の研究は、そんな未来で活躍するロボットの高度な知能を育てるために役立つものになるようです。

触れることで気持ちを理解する柔らかなロボット、そんな存在が人間とともに生活する時代が、いずれ来るのかもしれません。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)