システムがダウンロードされると勝手に画像データをスキャンしはじめる

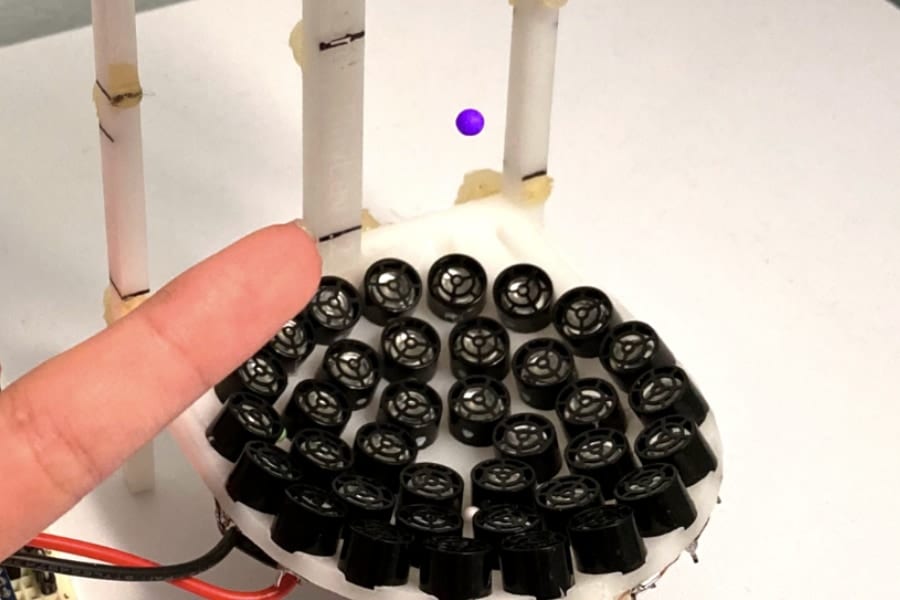

今年の後半からAppleが導入しようとしているシステムは「neural Hash」と呼ばれる検出アプリです。

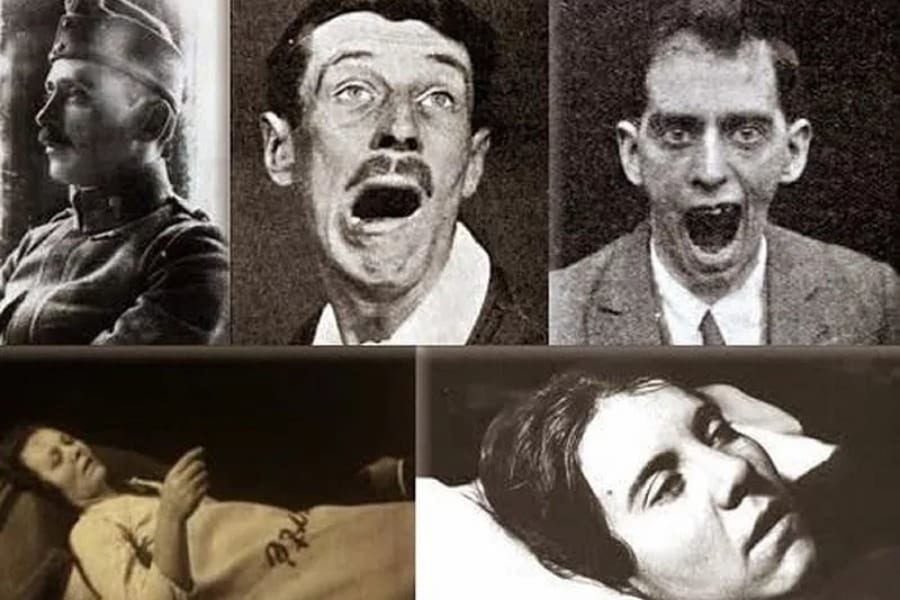

「neural Hash」は、児童ポルノとされた既存の20万枚の画像パターンをAIに学習させたアプリであり、iPhoneにダウンロードされると、似たようなパターンを持つ映像が個人のiPhone内部にあるかをスキャンしはじめます。

そしてパターン一致率が高い画像データが発見された場合、データがiPhoneから抜き取られて他者の手に渡り、警察に通報されます。

つまりAppleは膨大な量にのぼると考えられる被疑者に対して、通報するかしないかの裁量権を持つことになります。

また「neural Hash」は既にiPhoneにあるデータだけでなく、新たに送受信されるデータに対しても監視を行います。

例えば他人から子どもに送られてきた映像を、AIが児童ポルノだと判断した場合、写真は「ぼやける」だけでなく、子どもに対して警告が発せられ、「両親に通知する」とメッセージが表示されます。

また子ども自身が性的に露骨な写真を撮影したり、他者に送信しようとした場合も、同様の措置がとられます。

また監視対象は画像だけでなく言葉にも及ぶそう。

子どもや親が「児童ポルノ」にかかわる単語を検索した場合でもシステムが反応し、即座に警告を行うようになるからです。

これらの新たな監視システムに対して、一部の児童保護団体は歓迎の意向を示しています。

しかしセキュリティーの専門家たちは、大きな懸念を表明しています。

例えばジョンホプキンス大学のグリーン教授は、この種のツールは児童ポルノを見つけるために役立つとする一方で、AIの判断の元となっている「データベース」が、私たち一般の利用者が知ることができない点に問題があると述べました。

AIにターゲットを教えるデータベースを意図的に操作することで、個人のiPhoneから取り出したい画像を児童ポルノから別のものに簡単に変更することができるかもしれないからです。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)