脳波を読むだけで「聴いている音楽」がわかる

私たちの脳内では常に、電気信号を介してあらゆる情報処理が行われています。

言葉を話したり音楽を聴いたりすると、脳内のいたるところで電気信号が活発に発生しているのです。

研究チームはこれまで、脳内の信号から音響情報を解読して、人が聴いている音楽を特定するための非侵襲的な方法を模索し続けていました。

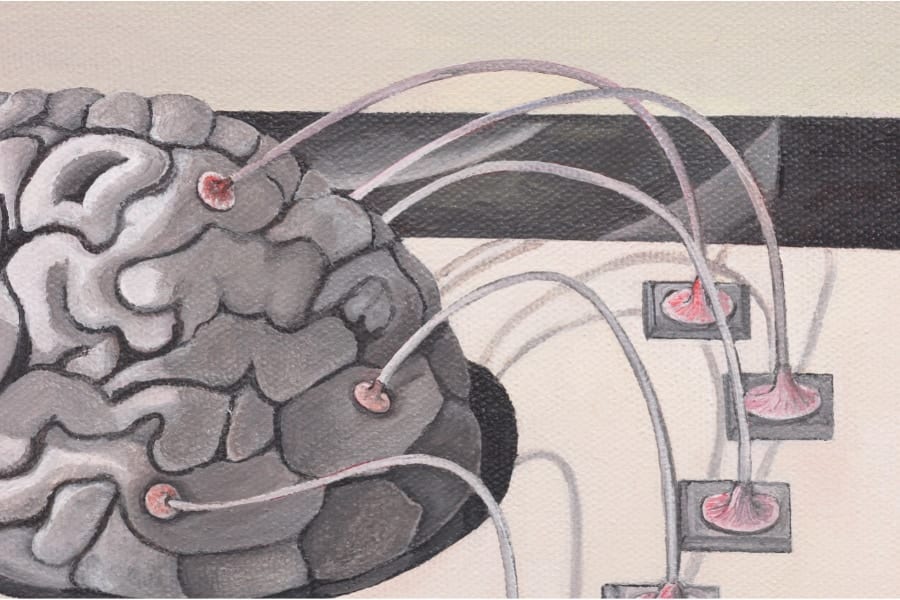

脳波から音響信号を再構築する研究は過去に成功例があるものの、それらは「皮質脳波(ECoG)」など侵襲性の高い方法が用いられています。

ECoGとは、脳の皮質表面にシート状の電極を貼付することにより電気的活動を計測する方法です。

そこで今回の研究では、脳全体の血流を測定する「磁気共鳴機能画像法(fMRI)」と、脳内で起きていることをリアルタイムで記録する「脳波(EEG)」の2つの安全な方法を組み合わせることにしました。

実験では、健康な成人男女20名を対象に、リズム・テンポ・ピッチ・ハーモニーが異なる36曲の簡単なピアノ曲を40秒ずつ聴いてもらいます。

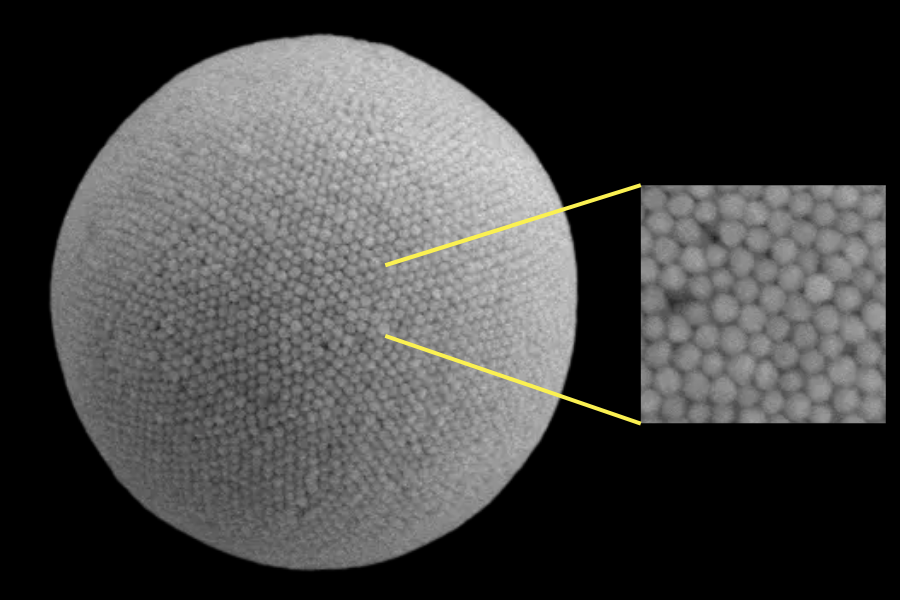

その後、収集された大量の脳活動データをAI(ニューラルネットワーク)に学習教材として与え、被験者に聞かせた楽曲と、それに応じて発生した脳活動の特徴を対応づけられるよう繰り返しトレーニング。

そして被験者の脳活動からリアルタイムで音響情報を解読し、聴いている楽曲を類推するAIモデルを構築しました。

このモデルを用いた実験の結果、71.8%の精度で被験者の聴いている音楽を識別することに成功しています。

またEEGデータのみを用いた場合でも、AIモデルは59.2%の精度で被験者の聴いている曲を当てられました。

成功率100%とはいきませんが、被験者数やトレーニング数を増やすことで、さらに精度も高まると考えられます。

本研究主任で、コンピューター科学・電子工学を専門とするイアン・デイリー(Ian Daly)氏は「音楽は複雑な音響信号であり、自然言語と多くの類似点があるため、このAIモデルは音声の翻訳に応用できる可能性がある」と話します。

というのも本研究の最終目標は、頭の中の言葉や思考を翻訳して、閉じ込め症候群のような重度コミュニケーション障害を持つ人々の支援に役立てることだからです。

閉じ込め症候群とは、意識はハッキリしているものの、全身が麻痺しているため、外界とのコミュニケーションが取れない病気を指します。

この状態の患者の多くは眼球運動の他には何もできなず、顔の表情すら動かせません。

またデイリー氏は「脳とコンピューターの間に直接通信路を設けるBCI(ブレイン・コンピューター・インターフェース)への応用も考えている」といいます。

BCIは「ブレイン・マシン・インターフェース(BMI)」とも呼ばれ、脳と機械を直接つないで、情報のやり取りを可能にする技術の総称です。

BCIはたとえば、重度の麻痺患者でも、頭で考えるだけで車椅子を動かしたり、ロボットアームを動かすといった応用が期待できます。

もちろん、これは険しい道のりですが、本研究の成果をBCIに応用すれば、患者が脳内で考えた言葉をロボットが代わりにリアルタイムで話してくれる技術の開発も可能かもしれません。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)