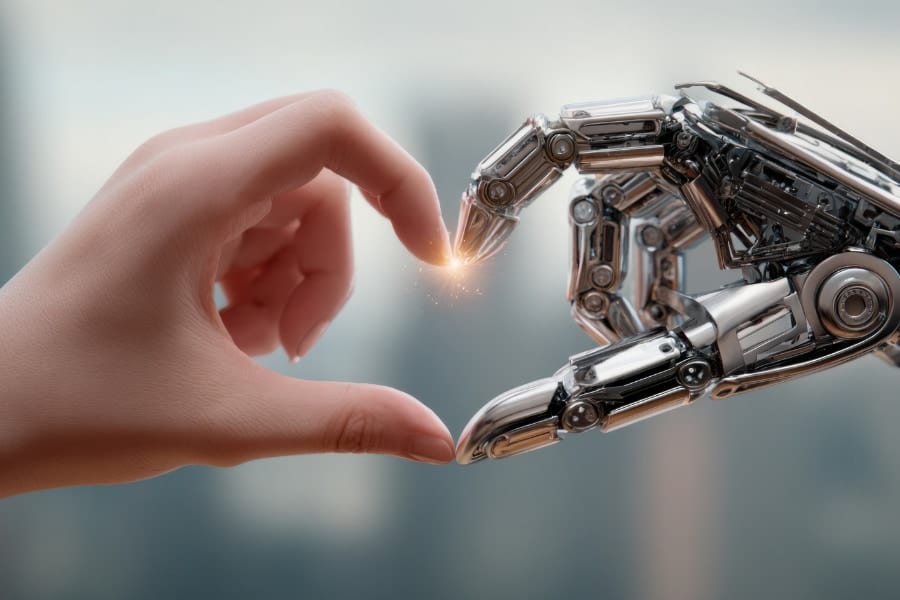

機械的ニューラルネットワークと生物学的ニューラルネットワークを繋ぐ

「ディープラーニングは脳をモデルにしている」とよく言われますが、実際には脳をそのままコピーしているわけではありません。

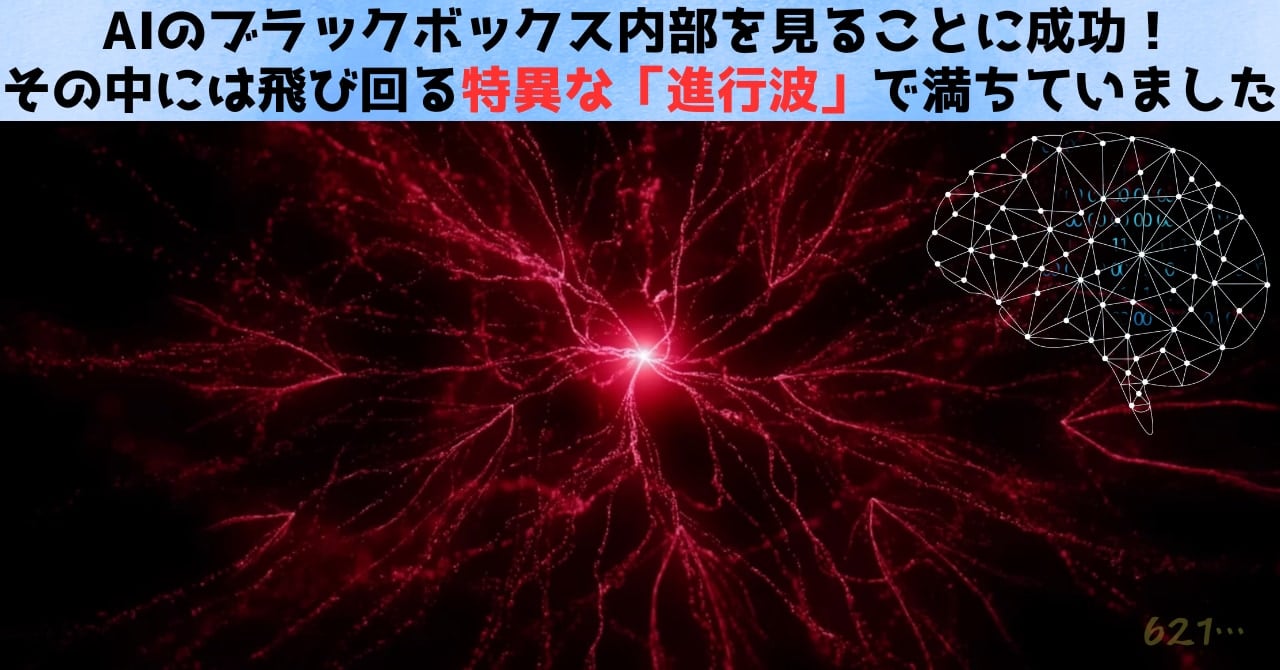

それでも、脳に似た構造や動きを取り入れると、計算上のメリットが得られる——“進行波”も、その一例です。

面白いのは、AIのために脳の進行波をモデル化していたら、逆に“脳そのもの”を理解する新たなヒントが見え始めたという点にあります。

脳の視覚野がわざわざ波を使って情報を伝えたりまとめたりしている理由を、人工的に波を再現したAIが“教えて”くれるかもしれないのです。

たとえるなら、「鳥の羽ばたきをまねて飛行機を作ろうとしていたら、逆に“鳥がどうやって空を飛べるのか”が分かってきた」というような状況です。

脳をまねたAIと、AIで脳を読み解く研究が同時に進んでいるのは、科学史上でも珍しい光景でしょう。

もし、人間の脳波や神経活動をAIの“進行波”として直接読み取れるようになったら、何が起こるでしょう?

ブレイン・マシン・インターフェース(BMI)がさらに進化して、人間の脳内で生まれる“コマンド波”がAIネットワークの波と共鳴する……。

そうなれば、思考そのものをダイレクトにロボットへ伝える未来だって夢物語ではありません。脳が「ここに動け」と指令を出すと、AI側で波が広がりロボットアームがスムーズに動く——そんなシーンが実現し得るのです。

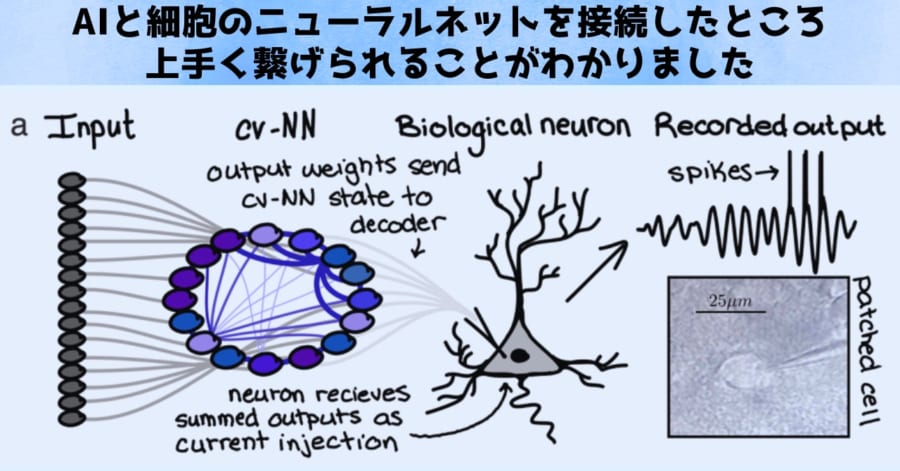

実際に、2024年には機械的ニューラルネットワークと生物学的ニューラルネットワークを結合し、生体側が機械側の情報を解読できることを示した研究も報告されています。

脳型AIを追求していたら、いつのまにか脳とAIが情報交換できる可能性まで見えてきた、というわけです。

もしこの技術が上手く発展していけば、進行波が人間の脳とAIの間を行き来することで、脳とAIの融合を実現できるかもしれません。

そして、もし進行波が人間の意識を運ぶ媒体となるならば、人間の進行波を受け取ったAIの中に、意識のようなものが芽生える可能性もあります。

さらに進行波に着目した内部が見えるAIの開発は、将来においても重要です。

AIを医療や自動運転などの分野で導入する際、「なぜその結論に至ったのか」を説明できるかどうかが大きな懸念材料とされています。

たとえば自動車の運転アルゴリズムに誤りがあった場合、それが“設計ミス”なのか、“想定外の環境”なのか、あるいは“学習データの偏り”なのかを明確にできなければ、責任の所在も対策も曖昧になってしまいます。

しかし、波のパターンを解析すれば、ネットワークがある入力画像に対してどう反応し、どのような経路を経てその判断に至ったのかを明確に辿る手がかりを得られます。

仮に誤った認識をしたとしても、「どの波の部分が異常な振る舞いを起こしたのか」を探り、再学習や調整を行いやすくなります。

さらに、波の様子を可視化ツールとして表現すれば、専門家以外でも“ざっくりとした判断根拠”を理解できる可能性が開けるでしょう。

このように、脳をまねるAIは、脳を理解する新たなチャンネルになり得るだけでなく、人間社会におけるAIの説明責任を果たすうえでも力を発揮してくれそうです。

波を解き明かすことは、脳とAIをつなぐカギであると同時に、私たちがAIをより安心して使うための指南役にもなるのかもしれません。

![[DABLOCKS] レザーケアセット 革靴 革ジャン 革製品 お手入れ](https://m.media-amazon.com/images/I/515FttM21TL._SL500_.jpg)

![[コロンブス] キレイな状態をキープ 長時間撥水 アメダス 防水・防汚スプレー420mL](https://m.media-amazon.com/images/I/31-OcmTs2LL._SL500_.jpg)

![シルバーバック【カンタン!たのしい!水の生きもの砂絵セット】 幼稚園 小学校 入園 入学 お祝い プレゼント 準備 ([バラエティ])](https://m.media-amazon.com/images/I/515gZ4F-QYL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

波によって人間の脳を真似るにあたり、人間が多くの動植物の中間に位置していることまでやるならやってほしいです。

人間の脳のみを真似していこうというのは、恐らく攻撃性が過ぎたり虚無的な回答に向かったりしやすいと思います。遊びや材料といった、構え、がないからです。

簡単に言うと、実用化するならば猫の飛び出しにも対応できる自動運転でなくてはなりません。周囲の動植物の目が波をより詳しく、より立体的に浮き彫りにしてくれます。

人の脳だけ真似ても、それらは得られない。

申し訳ありません。私はあなたの例えが理解できていません。猫の飛び出しを問題だと意識している動物は人間だけだと思うからです。

また、今回の進行波をAIに取り入れる実験での大きな要素ついてですが、「AIに人間の波を模倣させること」ではなく、「AIの波を知り“AIの頭の中”を可視化する大きな手がかりを手に入れたこと」が重要だったと思われます。

ニューラルネットワークは脳と似た構造や動きを取り入れ計算上のメリットを得ていますが、人間の脳のコピーではありません。ニューラルネットワークの波も、人間の脳の波のコピーではありません。ニューラルネットワーク独自の波になると思われます。

結果として空間的に分布した「波」と

脳みたいに時間発展している波を同列に比較していいのかね