なぜ赤ちゃんは意味を知り、AIは知らない? 発達心理学から読み解く背景

近年、ChatGPTのように膨大な文章データをもとに言語処理を行う大規模言語モデルが注目を集めています。

これらのモデルは非常に流暢に文章を生成できますが、実際には「意味を体験的に理解する」という点が十分でないという指摘があります。

たとえば「熱い」「軽い」といった言葉を、人間は直接触れたり持ち上げたりする経験を通じて感覚と結びつけます。

しかし、大規模言語モデルは文字情報だけで学習しているため、実際にものを触る体験や行動の試行錯誤を含まないのです。

一方で、人間の赤ちゃんは自分の体験を通じて言葉を覚えます。

たとえば赤ちゃんは、転んで痛い思いをしながら「痛い」という言葉を学び、熱いお湯に触れて「熱い」を知るように、行動と感覚を重ね合わせながら言語を身につけていきます。

こうした「身体を通した学習」は、ただ単に単語を記憶するだけでなく、その背後にある現実の状況や行為を理解するうえで欠かせないプロセスです。

今回の沖縄科学技術大学院大学(OIST)の研究は、ロボットに「赤ちゃんが言語を覚えるようなプロセス」を取り入れることで、言葉と行動を同時に学習できるAIをめざしています。

これまでは「ロボットは指示どおりに動くが、その言葉の意味を本当に理解しているわけではない」というイメージが強かったかもしれません。

しかし、実際にブロックをつかんだり動かしたりする経験から、言葉と動作が密接に結びつくならば、AIも「赤ちゃんのように」意味をつかめる可能性があるのです。

これは従来のテキストベースの学習だけでは得られない、人間に近い理解の仕組みを作り出すうえで大きな一歩といえます。

研究では、まずロボットアームにカメラを取り付け、白いテーブルの上に置かれた複数の色のブロックを見せながら「赤いブロックを左へ動かして」「緑のブロックを青の上に載せて」などの指令を与えました。

ブロックは赤・緑・青・黄・紫の5色で、それぞれの色を表す単語(名詞)と、“つかむ”“動かす”“上に置く”など合計8種類の動作(動詞)を組み合わせて学習させたのです。

学習自体は、ロボットが実際にブロックをつかんで動かし、カメラ映像やアームの動きを見比べながら「言葉と行動」を同時に覚えていくという仕組みで進められました。

(※この研究では、人間が脳内で行っていると考えられる「予測と誤差修正」のメカニズムをAIモデルにも取り入れている。

専門的には「予測コーディング(Predictive Coding)」や「自由エネルギー原理(Free-Energy Principle)」と呼ばれ、赤ちゃんが体験を通じて世界を理解する過程の理論的モデルを応用している。)

驚くべきは、このようにして言葉を身につけたロボットが、学んだことのない単語の組み合わせでも“正しく”動作を推測できるようになった点です。

たとえば「move red left(赤いブロックを左へ動かす)」と「put green on blue(緑色のブロックを青色の上に置く)」を別々に学習していたロボットが、まだ聞いたことのない「put red on blue(赤色を青色の上に置く)」という指令を受けても、その意味を理解してブロックを積めるようになったのです。

この結果は、単に音声やテキストとして“言葉”を覚えるだけでなく、実際の動作と結びつけることで、ロボットが人間に近い柔軟な理解の仕組みを獲得し始めていることを示唆しています。

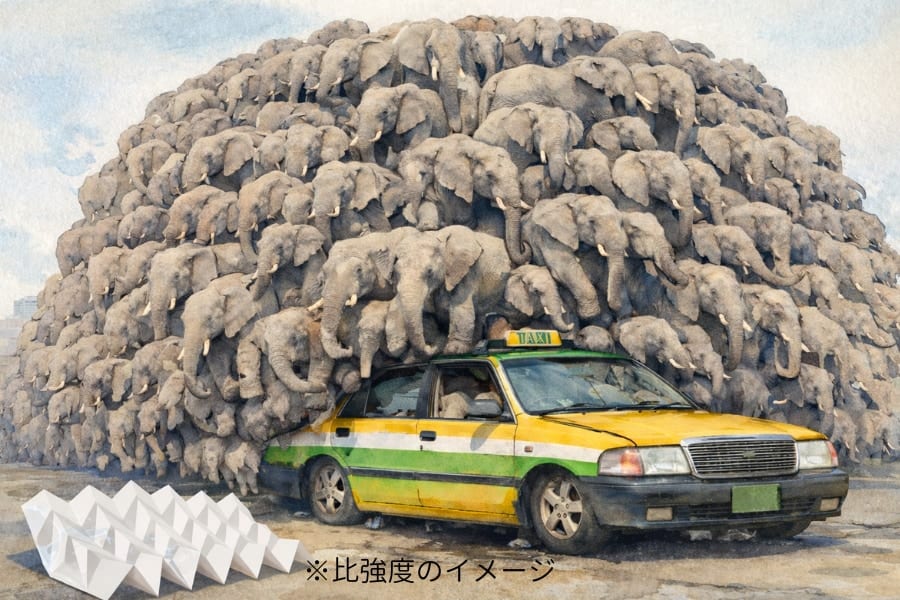

実際には64×64ピクセルという低解像度の映像しか見えないロボットにとって、ブロックの位置や色を見分け、正しく動かすのは簡単ではありません。

それでもこの方法で訓練されたAIは、物体の特徴や動き、さらに言語表現を関連づけて考えられるようになりました。

結果として、人間が新たに与えた指令文に対しても、それを“再利用”して自分なりの行動プランを立てられるというわけです。

こうした汎化(一般化)の力こそが、今回の実験で最大の注目点と言えるでしょう。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)