なぜ『脳型ビジョン』が必要か?

私たちの脳は視覚情報を効率的に処理し、必要なことだけを素早く判断します。

これに対して従来のデジタルカメラやコンピューターでは、映像をコマ送り(フレームごと)に取得し、大量のデータを逐次処理していました。

データ量が膨大になるほど処理に時間と電力を要し、リアルタイムに判断することが難しくなります。

この問題を解決するために登場したのがニューロモルフィック・ビジョンと呼ばれる技術です。

ニューロモルフィック(神経模倣)とは脳神経の働きを模倣するという意味で、人間の脳のようなアナログ信号処理を用いることで、従来のデジタル方式よりもはるかに省エネルギーで高度な視覚情報処理を実現しようとする試みです。

実際、研究リーダーのスミート・ワリア教授は「ニューロモルフィックな視覚システムは私たちの脳に近いアナログ処理を行うため、現在のデジタル技術よりも複雑な視覚タスクに必要なエネルギーを大幅に削減できます」と指摘しています。

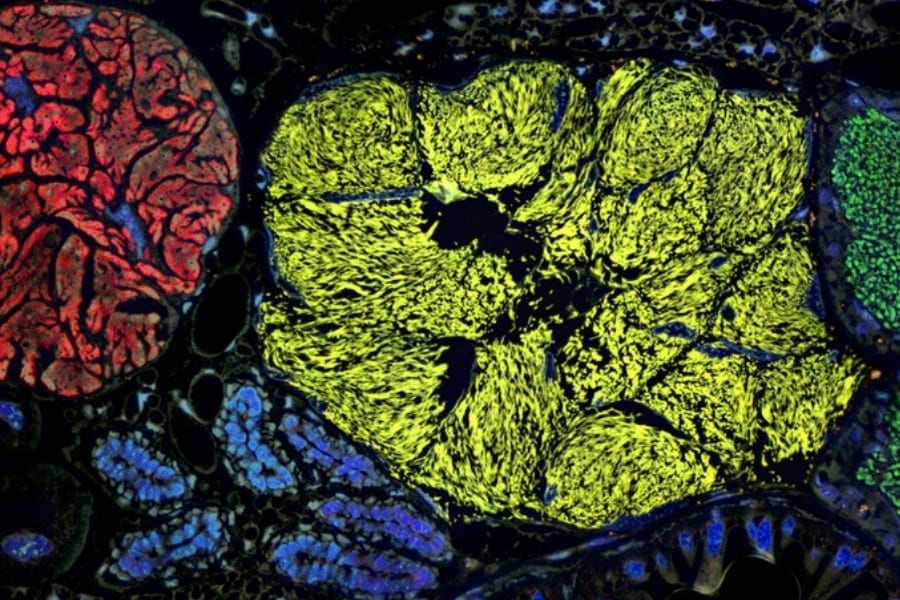

脳を模倣したコンピューティングの核となるのがスパイキング・ニューラルネットワーク(SNN)と呼ばれる仕組みです。

これは、生物のニューロン(神経細胞)が電気パルス(スパイク)を発する挙動を再現したもので、信号が一定量蓄積されて閾値に達すると“発火”し、その後ニューロンがリセットされる漏れ積分発火(LIF)モデルが基本となっています。

SNNは不要な情報を抑えて必要な時だけスパイクを出力するため、省電力かつ生物に近い情報処理が可能です。

しかし、実際にこのようなニューロンの動きをデバイス上で再現し、カメラのような視覚センサーと統合することは大きな課題でした。

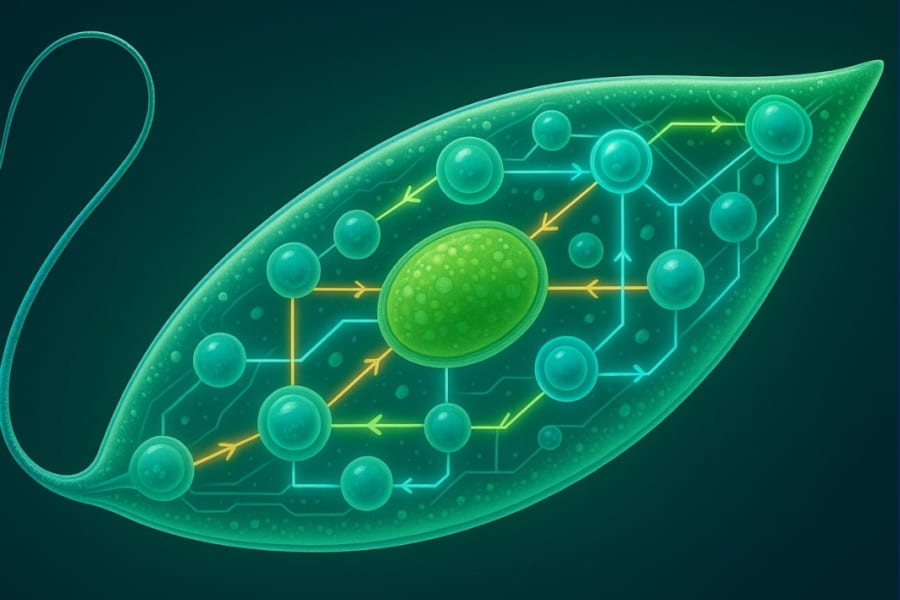

研究チームはこの課題に挑み、モリブデンジスルフィド(MoS₂)と呼ばれる原子レベルに薄い半導体材料を用いて、光で動作する人工ニューロンを作り出すことを目指しました。

MoS₂などの二次元材料は厚さ数原子のシート状物質で、電子的・光学的性質を電圧で細かく制御でき、省電力で柔軟なデバイス設計が可能になることから注目されています。

今回の研究では、この超薄型MoS₂に意図的に微小な欠陥(原子レベルの不完全構造)を導入し、光に対してニューロンのような応答を引き出せるかを探りました。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)