AIがオープンワールドで遊ぶとは何を意味するか?

強化学習という言葉を聞くと、難しそうな数式や専門的なアルゴリズムを連想するかもしれません。

しかしその本質は、まるで子どもが自転車に乗れるようになるまで何度も転んでは起き上がるように、「トライ&エラーを繰り返して少しずつ学習する」という仕組みです。

最初は失敗ばかりでも、成功に近づくたびに「ご褒美」を受け取り、そのご褒美を最大化しようと行動を改良していく──そんなシンプルなイメージが強化学習の原点です。

ところが、実際には大きな壁がありました。

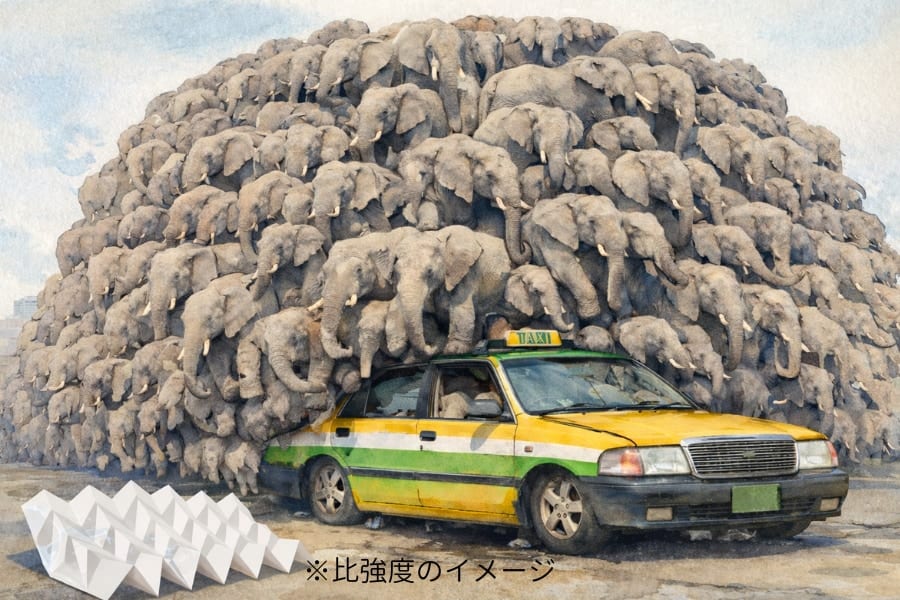

多くの強化学習システムは「ゲームや環境によって細かいパラメータを変えないと、まともに学習できない」ことがしばしば起こります。

たとえば、難易度が高いゲームでは報酬を少し増やし、反対に報酬が簡単に取れすぎるゲームでは少し減らす、といった具合です。

これはちょうど、服のサイズが合わないたびに仕立て直しを繰り返しているようなもので、煩わしさが拭えません。

もし「着る人を選ばないフリーサイズのスーツ」が手に入るなら、そのほうが手間もかからず便利でしょう。

強化学習の研究コミュニティでは、こうした“調整なしでも多様なタスクをこなせるAI”を目指すアプローチが何年も議論されてきました。

そんな流れのなかでも、“マインクラフト”はとりわけ難しく、しかも魅力的な実験台です。

一言でいえば、“巨大な砂場”のような世界が広がっていて、プレイヤーはいろんなものを作れますし、どこへでも行けます。

資源を集め、道具を作り、道具を使ってさらに新しいものを作る、という果てしないサイクルが続きます。

自由度が高いぶん、「何から手をつけるかすら分からない」という問題も出てきます。

ゲーム上級者は攻略サイトで知識を仕入れたり、先人のミスを学んだりしながら少しずつ上手くなるのですが、それをAIがいきなり全部ひとりでやれと言われたら、相当骨が折れるのは容易に想像できます。

中でも“ダイヤモンドの入手”は多くのプレイヤーが「ひと苦労した」と口をそろえるハードルで、人間にとってもやり込み甲斐のある大目標です。

実際、これまでの研究では「AIがマインクラフトを上手にプレイする」ためには、人間が事前に教えるステップが不可欠なケースが大半でした。

たとえば、「まずは木を切り、それを使って道具を作り……」といった手順を人間のプレイデータから学ばせるとか、難易度を段階的に設定するカリキュラムを用意してあげるとか。

これは確かに効果的ですが、一方で「AIが本当にゼロから自力で学習しきった」とは言い難いのも事実です。

もし何の助けもなく、ただ試行錯誤するだけでダイヤモンドまでたどり着けるなら、それは「地図のない広大な島に放り出されても、AIがサバイバル術を自前で身につけられる」ということを意味します。

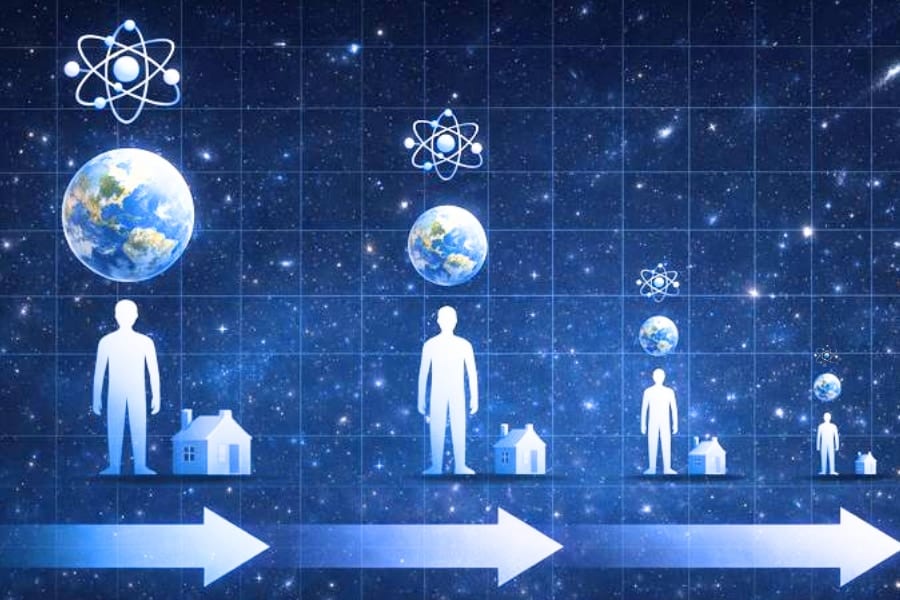

そこで重要になってくるのが、「世界モデル(World Model)」という考え方です。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)