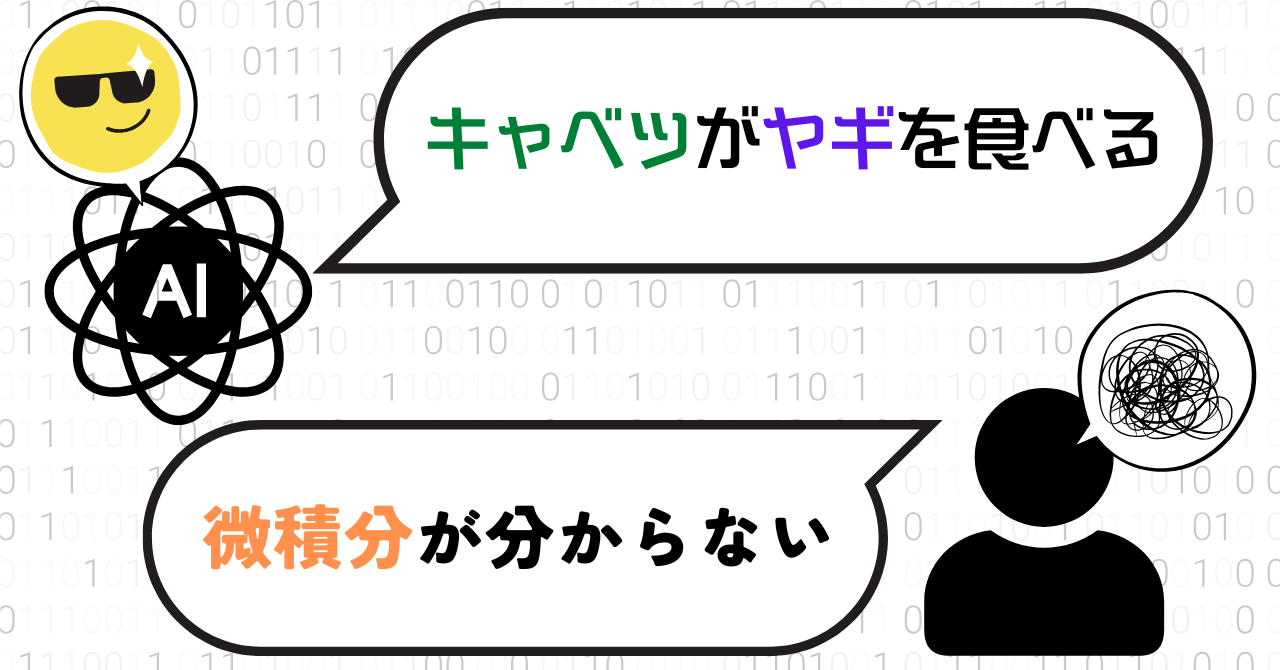

自信満々に大きなミスを犯すAI

AIのミスは、人間のミスとは大きく異なります。

ChatGPTなどの大規模言語モデル(LLM: Large Language Model)は、膨大なデータを学習して非常に広範な知識を持っているように見えますが、人間が絶対にしないような奇妙なミスを犯すことがあります。

その特徴の一つは、ミスが特定のトピックや条件に依存せず、予測が非常に難しいことです。

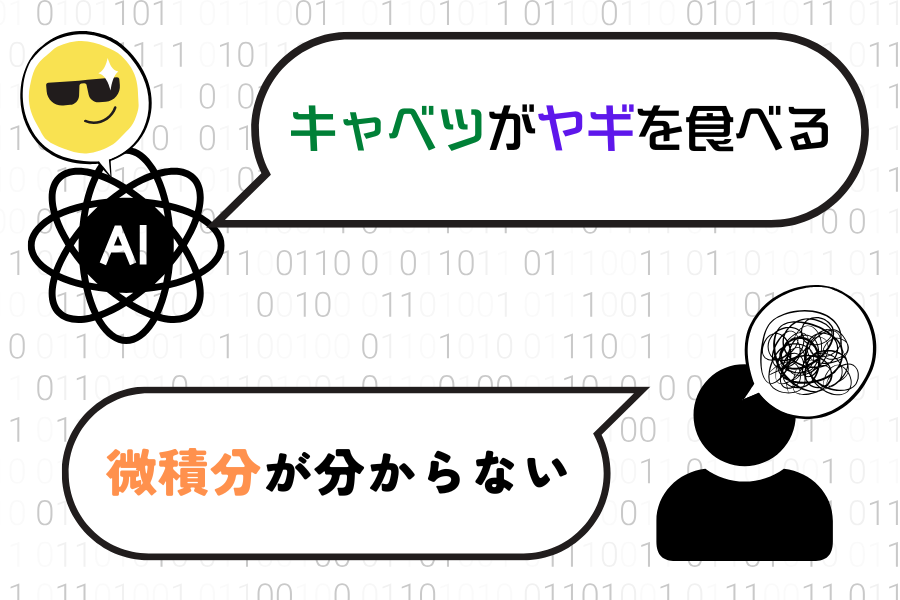

例えば、AIは高度な微積分の問題を正確に解ける一方で、「キャベツがヤギを食べる」といった荒唐無稽な文章を出力することがあります。

この奇妙な挙動の背景には、AIの知識が人間のように体系的に整理されておらず、断片的であることが挙げられます。

人間の場合、知識は経験や常識によって関連付けられたネットワーク状に構築されています。

しかしAIの知識は膨大なデータを基にした統計的な関連性に依存しています。

そのため、AIは特定の知識領域に限定されずに幅広い問題に対応できますが、文脈や常識に基づかない突飛な回答を出すことがあるのです。

人間の間違いは知識不足によって生じることが多いですが、AIの間違いの原因は知識不足ではありません。

AIにとっては、微積分を間違う確率と「キャベツがヤギを食べる」と言ってしまう確率は同じかもしれないのです。

さらに、AIは自信を持って誤った情報を出力する傾向があります。

このような自信過剰な挙動は、ユーザーがAIの回答を信頼してしまい、間違った結論を引き出すリスクを高めます。

人間であれば、自分の提出した回答に対して、「ちょっと分からない」「自信がない」と付け足すものですが、AIはいつでも自信満々であり、自己認識に欠けています。

加えて、AIは知識の一貫性を保つのが苦手であり、長い文章や複雑な文脈では冒頭や結末の情報を覚えていても、中間部分を忘れることがあります。

このため、複雑なタスクの処理中に矛盾した情報が出力されることがあります。

人間も確かに「過去の自分の発言を忘れる」ことがあるため、そういった点ではAIと似ているかもしれません。

しかしAIの場合は、「ほんの少し前の、もしくは今まさに出力していた言葉との関連を考慮しないことがある」という点で特殊です。

こうして考えていくと、確かにAIのミスと人間のミスは大きく異なります。

だからこそ、人間がこれまで自分たちに当てはめてきた対策が通用しません。

では、私たちがAIを活用していく上で、AIのミスに対してどのように対処できるでしょうか。

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)