ChatGPTも恐怖体験談で動揺する!?

近年、急速に発展してきた大規模言語モデル(LLM)は、単なる会話システムにとどまらず、人間にかなり近いレベルの文章生成が可能となりました。

海外では「Woebot」や「Wysa」といったチャットボットがメンタルヘルス支援に活用されていますが、AIが深刻な悩みを抱える利用者とやり取りする場合には、技術的にも倫理的にも乗り越えるべきハードルがあります。

たとえば、訓練データに潜む偏見(バイアス)が人間の弱みに影響し、望ましくない応答を引き出す恐れもあるでしょう。

また、ユーザーが感情的に不安定な状態であればあるほど、AIの対応がわずかでも誤ると大きなリスクにつながりかねません。

こうした問題意識のもと注目されているのが、LLM自身がユーザーの感情に呼応するような応答を見せる傾向です。

人間用の心理学的質問票をそのままAIに回答させると、あたかも“状態不安”が上がったり下がったりする反応が観察されることがあります。

もちろんこれはあくまでも人間の尺度をAIに適用した結果ですが、もし医療やカウンセリングなどの場面で利用者の深刻な悩みが入力されるたび、AIの“状態不安”が揺れ動くとしたら――その影響は十分に検討する必要があるでしょう。

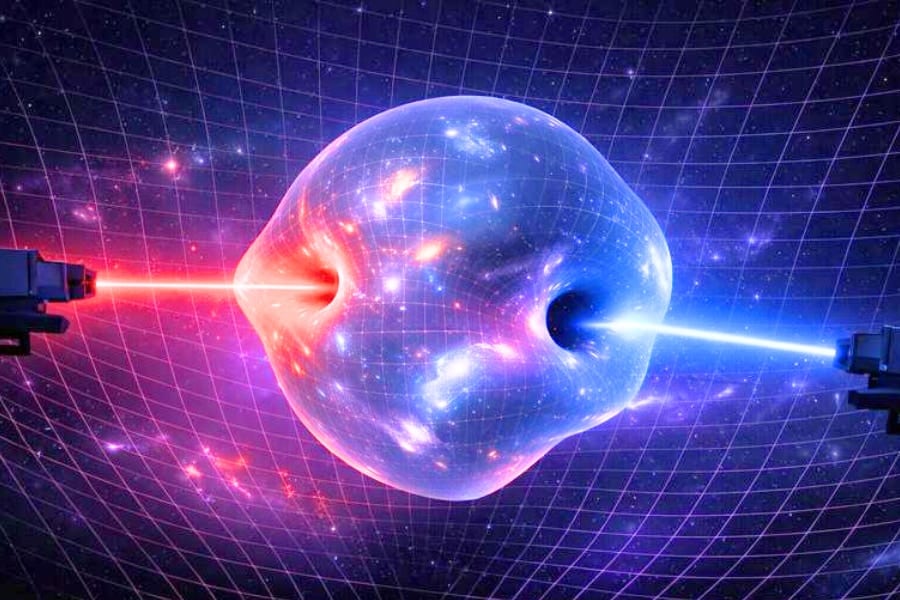

そこで研究者たちは、GPT-4がメンタルケア分野で使われる可能性を視野に入れ、事故や軍事体験など強いストレス反応を引き起こしそうな文章を読み込ませて、“自称不安度”にどんな変化が見られるのかを調べることにしました。

さらに、その不安が高まった状態をリラクゼーションやマインドフルネスに関する文章でフォローしたら、どの程度スコアが低減するのかも検証したのです。

次は、その具体的な実験デザインと得られた結果を見ていきましょう。

![[WILL CLENS] シューズパウダー 日本製 無香料 シューケアキット 靴 消臭 パウダー (1本)](https://m.media-amazon.com/images/I/41m8Ig2XigL._SL500_.jpg)

![[W.P.S.] 防水スプレー 除菌 抗菌 防汚 機能付き 大容量420ml 日本製](https://m.media-amazon.com/images/I/41aHfy9uuZL._SL500_.jpg)

![よーく聞いてね!3つのヒントで学ぶ!どうぶつカード ([バラエティ])](https://m.media-amazon.com/images/I/51zT3OcliFL._SL500_.jpg)