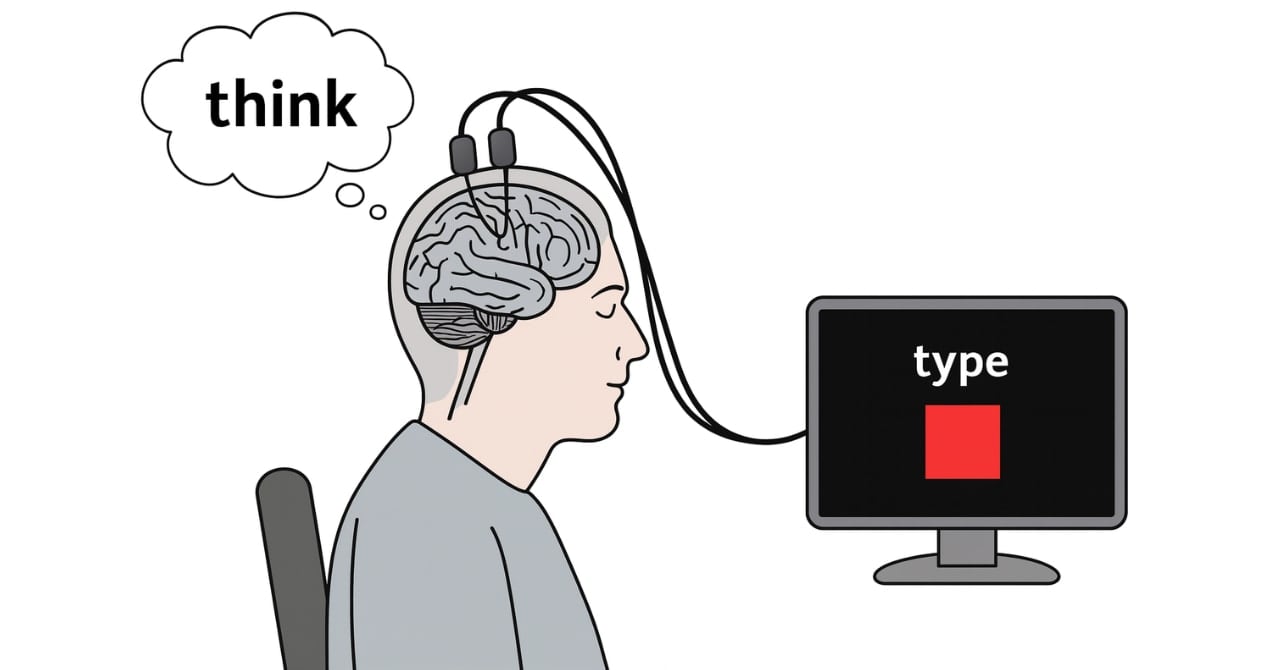

脳が生む「心の声」を読み取る

人は日常的に「心の声」を使っています。

頭の中で文章を黙読したり、次にやることを段取りしたり、心の中で「3、2、1」と数えたり──これらはすべて「内的言葉」と呼ばれる現象です。

研究チームは、脳卒中やALS(筋萎縮性側索硬化症)などで言葉を発することが困難な4人の参加者の脳に微小な電極を埋め込み、その活動を記録しました。

参加者は「実際に声に出す」「声に出そうとする」「心の中で言う」「読む」「聞く」といった複数の課題を行い、脳信号の違いが解析されました。

その結果、脳の「運動皮質」と呼ばれる領域では、実際に声を出すときと心の中で同じ言葉をつぶやくときで、非常によく似た活動パターンが生じていることが確認されました。

ただし、内的言葉は声を出そうとする場合に比べて全体的に弱い信号しか発していません。

それでもAIを用いたモデルは、この微弱な信号から驚くほどの精度で言葉を復元することに成功しました。

さらに研究では、参加者に実際に声を出さなくても「心の中で文を話す」よう指示すると、その文をリアルタイムで解読することに成功しました。

最大12万5000語という大規模な語彙の中から、誤り率26〜54%の範囲で文を当てることができ、これは内的言葉の解読としては過去最高の精度です。

興味深いことに、チームは「無意識に生じる心の声」までも検出できることを示しました。

例えば、画面に表示された矢印の並びを覚える課題では、多くの参加者が「上、右、上」といった具合に心の中で言葉を繰り返していたと考えられ、その信号をBCIが捉えることができたのです。

また「数を数える課題」では、頭の中で進行している数字のカウントが実際に脳信号から読み取られました。

つまりこの技術は、単に「指示された心の声」を読むだけでなく、自然に生じる内的言葉まで拾い上げてしまう可能性があることを示したのです。

![【カンタン!たのしい!どうぶつ砂絵セット】 知育玩具のシルバーバック 幼稚園 小学校 入園 入学 お祝い プレゼント 準備 ([バラエティ])](https://m.media-amazon.com/images/I/51Ng7flKVxL._SL500_.jpg)